| CSDN博客推荐文章CSDN博客内容聚合服务 |

| Java提高配(三七)—–Java集合细节(三):subList的缺陷 | ||||||||||||

|

我们经常使用subString方法来对String对象进行分割处理,同时我们也可以使用subList、subMap、subSet来对List、Map、Set进行分割处理,但是这个分割存在某些瑕疵。 一、subList返回仅仅只是一个视图首先我们先看如下实例: public static void main(String[] args) {

List<Integer> list1 = new ArrayList<Integer>();

list1.add(1);

list1.add(2);

//通过构造函数新建一个包含list1的列表 list2

List<Integer> list2 = new ArrayList<Integer>(list1);

//通过subList生成一个与list1一样的列表 list3

List<Integer> list3 = list1.subList(0, list1.size());

//修改list3

list3.add(3);

System.out.println("list1 == list2:" + list1.equals(list2));

System.out.println("list1 == list3:" + list1.equals(list3));

}这个例子非常简单,无非就是通过构造函数、subList重新生成一个与list1一样的list,然后修改list3,最后比较list1 == list2?、list1 == list3?。按照我们常规的思路应该是这样的:因为list3通过add新增了一个元素,那么它肯定与list1不等,而list2是通过list1构造出来的,所以应该相等,所以结果应该是: list1 == list2:true list1 == list3: false 首先我们先不论结果的正确与否,我们先看subList的源码: public List<E> subList(int fromIndex, int toIndex) {

subListRangeCheck(fromIndex, toIndex, size);

return new SubList(this, 0, fromIndex, toIndex);

}subListRangeCheck方式是判断fromIndex、toIndex是否合法,如果合法就直接返回一个subList对象,注意在产生该new该对象的时候传递了一个参数 this ,该参数非常重要,因为他代表着原始list。 /**

* 继承AbstractList类,实现RandomAccess接口

*/

private class SubList extends AbstractList<E> implements RandomAccess {

private final AbstractList<E> parent; //列表

private final int parentOffset;

private final int offset;

int size;

//构造函数

SubList(AbstractList<E> parent,

int offset, int fromIndex, int toIndex) {

this.parent = parent;

this.parentOffset = fromIndex;

this.offset = offset + fromIndex;

this.size = toIndex - fromIndex;

this.modCount = ArrayList.this.modCount;

}

//set方法

public E set(int index, E e) {

rangeCheck(index);

checkForComodification();

E oldValue = ArrayList.this.elementData(offset + index);

ArrayList.this.elementData[offset + index] = e;

return oldValue;

}

//get方法

public E get(int index) {

rangeCheck(index);

checkForComodification();

return ArrayList.this.elementData(offset + index);

}

//add方法

public void add(int index, E e) {

rangeCheckForAdd(index);

checkForComodification();

parent.add(parentOffset + index, e);

this.modCount = parent.modCount;

this.size++;

}

//remove方法

public E remove(int index) {

rangeCheck(index);

checkForComodification();

E result = parent.remove(parentOffset + index);

this.modCount = parent.modCount;

this.size--;

return result;

}

}该SubLsit是ArrayList的内部类,它与ArrayList一样,都是继承AbstractList和实现RandomAccess接口。同时也提供了get、set、add、remove等list常用的方法。但是它的构造函数有点特殊,在该构造函数中有两个地方需要注意: 1、this.parent = parent;而parent就是在前面传递过来的list,也就是说this.parent就是原始list的引用。 2、this.offset = offset + fromIndex;this.parentOffset = fromIndex;。同时在构造函数中它甚至将modCount(fail-fast机制)传递过来了。 我们再看get方法,在get方法中return ArrayList.this.elementData(offset + index);这段代码可以清晰表明get所返回就是原列表offset + index位置的元素。同样的道理还有add方法里面的: parent.add(parentOffset + index, e); this.modCount = parent.modCount; remove方法里面的 E result = parent.remove(parentOffset + index); this.modCount = parent.modCount; 诚然,到了这里我们可以判断subList返回的SubList同样也是AbstractList的子类,同时它的方法如get、set、add、remove等都是在原列表上面做操作,它并没有像subString一样生成一个新的对象。所以subList返回的只是原列表的一个视图,它所有的操作最终都会作用在原列表上。 那么从这里的分析我们可以得出上面的结果应该恰恰与我们上面的答案相反: list1 == list2:false list1 == list3:true

二、subList生成子列表后,不要试图去操作原列表从上面我们知道subList生成的子列表只是原列表的一个视图而已,如果我们操作子列表它产生的作用都会在原列表上面表现,但是如果我们操作原列表会产生什么情况呢? public static void main(String[] args) {

List<Integer> list1 = new ArrayList<Integer>();

list1.add(1);

list1.add(2);

//通过subList生成一个与list1一样的列表 list3

List<Integer> list3 = list1.subList(0, list1.size());

//修改list3

list1.add(3);

System.out.println("list1'size:" + list1.size());

System.out.println("list3'size:" + list3.size());

}该实例如果不产生意外,那么他们两个list的大小都应该都是3,但是偏偏事与愿违,事实上我们得到的结果是这样的: list1'size:3

Exception in thread "main" java.util.ConcurrentModificationException

at java.util.ArrayList$SubList.checkForComodification(Unknown Source)

at java.util.ArrayList$SubList.size(Unknown Source)

at com.chenssy.test.arrayList.SubListTest.main(SubListTest.java:17)list1正常输出,但是list3就抛出ConcurrentModificationException异常,看过我另一篇博客的同仁肯定对这个异常非常,fail-fast?不错就是fail-fast机制,在fail-fast机制中,LZ花了很多力气来讲述这个异常,所以这里LZ就不对这个异常多讲了(更多请点这里:Java提高篇(三四)—–fail-fast机制)。我们再看size方法: public int size() {

checkForComodification();

return this.size;

}size方法首先会通过checkForComodification验证,然后再返回this.size。 private void checkForComodification() {

if (ArrayList.this.modCount != this.modCount)

throw new ConcurrentModificationException();

}该方法表明当原列表的modCount与this.modCount不相等时就会抛出ConcurrentModificationException。同时我们知道modCount 在new的过程中 “继承”了原列表modCount,只有在修改该列表(子列表)时才会修改该值(先表现在原列表后作用于子列表)。而在该实例中我们是操作原列表,原列表的modCount当然不会反应在子列表的modCount上啦,所以才会抛出该异常。 对于子列表视图,它是动态生成的,生成之后就不要操作原列表了,否则必然都导致视图的不稳定而抛出异常。最好的办法就是将原列表设置为只读状态,要操作就操作子列表: //通过subList生成一个与list1一样的列表 list3

List<Integer> list3 = list1.subList(0, list1.size());

//对list1设置为只读状态

list1 = Collections.unmodifiableList(list1);

三、推荐使用subList处理局部列表在开发过程中我们一定会遇到这样一个问题:获取一堆数据后,需要删除某段数据。例如,有一个列表存在1000条记录,我们需要删除100-200位置处的数据,可能我们会这样处理: for(int i = 0 ; i < list1.size() ; i++){

if(i >= 100 && i <= 200){

list1.remove(i);

/*

* 当然这段代码存在问题,list remove之后后面的元素会填充上来,

* 所以需要对i进行简单的处理,当然这个不是这里讨论的问题。

*/

}

}这个应该是我们大部分人的处理方式吧,其实还有更好的方法,利用subList。在前面LZ已经讲过,子列表的操作都会反映在原列表上。所以下面一行代码全部搞定: list1.subList(100, 200).clear(); 简单而不失华丽!!!!! 参考资料:编写高质量代码:改善Java程序的151个建议

作者:chenssy 发表于2015/3/6 18:20:06 原文链接

阅读:3040 评论:7 查看评论

| ||||||||||||

| Java提高篇(三六)-----java集合细节(二):asList的缺陷 | ||||||||||||

|

在实际开发过程中我们经常使用asList讲数组转换为List,这个方法使用起来非常方便,但是asList方法存在几个缺陷: 一、避免使用基本数据类型数组转换为列表使用8个基本类型数组转换为列表时会存在一个比较有味的缺陷。先看如下程序: public static void main(String[] args) {

int[] ints = {1,2,3,4,5};

List list = Arrays.asList(ints);

System.out.println("list'size:" + list.size());

}

------------------------------------

outPut:

list'size:1程序的运行结果并没有像我们预期的那样是5而是逆天的1,这是什么情况?先看源码: public static <T> List<T> asList(T... a) {

return new ArrayList<>(a);

}asList接受的参数是一个泛型的变长参数,我们知道基本数据类型是无法发型化的,也就是说8个基本类型是无法作为asList的参数的, 要想作为泛型参数就必须使用其所对应的包装类型。但是这个这个实例中为什么没有出错呢?因为该实例是将int 类型的数组当做其参数,而在Java中数组是一个对象,它是可以泛型化的。所以该例子是不会产生错误的。既然例子是将整个int 类型的数组当做泛型参数,那么经过asList转换就只有一个int 的列表了。如下: public static void main(String[] args) {

int[] ints = {1,2,3,4,5};

List list = Arrays.asList(ints);

System.out.println("list 的类型:" + list.get(0).getClass());

System.out.println("list.get(0) == ints:" + list.get(0).equals(ints));

}

--------------------------------------------

outPut:

list 的类型:class [I

list.get(0) == ints:true从这个运行结果我们可以充分证明list里面的元素就是int数组。弄清楚这点了,那么修改方法也就一目了然了:将int 改变为Integer。 public static void main(String[] args) {

Integer[] ints = {1,2,3,4,5};

List list = Arrays.asList(ints);

System.out.println("list'size:" + list.size());

System.out.println("list.get(0) 的类型:" + list.get(0).getClass());

System.out.println("list.get(0) == ints[0]:" + list.get(0).equals(ints[0]));

}

----------------------------------------

outPut:

list'size:5

list.get(0) 的类型:class java.lang.Integer

list.get(0) == ints[0]:true>>>>>>Java细节(2.1):在使用asList时不要将基本数据类型当做参数。 二、asList产生的列表不可操作对于上面的实例我们再做一个小小的修改: public static void main(String[] args) {

Integer[] ints = {1,2,3,4,5};

List list = Arrays.asList(ints);

list.add(6);

}该实例就是讲ints通过asList转换为list 类别,然后再通过add方法加一个元素,这个实例简单的不能再简单了,但是运行结果呢?打出我们所料: Exception in thread "main" java.lang.UnsupportedOperationException

at java.util.AbstractList.add(Unknown Source)

at java.util.AbstractList.add(Unknown Source)

at com.chenssy.test.arrayList.AsListTest.main(AsListTest.java:10)运行结果尽然抛出UnsupportedOperationException异常,该异常表示list不支持add方法。这就让我们郁闷了,list怎么可能不支持add方法呢?难道jdk脑袋堵塞了?我们再看asList的源码: public static <T> List<T> asList(T... a) {

return new ArrayList<>(a);

}asList接受参数后,直接new 一个ArrayList,到这里看应该是没有错误的啊?别急,再往下看: private static class ArrayList<E> extends AbstractList<E>

implements RandomAccess, java.io.Serializable{

private static final long serialVersionUID = -2764017481108945198L;

private final E[] a;

ArrayList(E[] array) {

if (array==null)

throw new NullPointerException();

a = array;

}

//.................

}这是ArrayList的源码,从这里我们可以看出,此ArrayList不是java.util.ArrayList,他是Arrays的内部类。该内部类提供了size、toArray、get、set、indexOf、contains方法,而像add、remove等改变list结果的方法从AbstractList父类继承过来,同时这些方法也比较奇葩,它直接抛出UnsupportedOperationException异常: public boolean add(E e) {

add(size(), e);

return true;

}

public E set(int index, E element) {

throw new UnsupportedOperationException();

}

public void add(int index, E element) {

throw new UnsupportedOperationException();

}

public E remove(int index) {

throw new UnsupportedOperationException();

}通过这些代码可以看出asList返回的列表只不过是一个披着list的外衣,它并没有list的基本特性(变长)。该list是一个长度不可变的列表,传入参数的数组有多长,其返回的列表就只能是多长。所以: >>>>>>Java细节(2.2):不要试图改变asList返回的列表,否则你会自食苦果。

作者:chenssy 发表于2014/8/4 19:24:29 原文链接

阅读:2775 评论:0 查看评论

| ||||||||||||

| Java提高篇(三五)-----Java集合细节(一):请为集合指定初始容量 | ||||||||||||

|

集合是我们在Java编程中使用非常广泛的,它就像大海,海纳百川,像万能容器,盛装万物,而且这个大海,万能容器还可以无限变大(如果条件允许)。当这个海、容器的量变得非常大的时候,它的初始容量就会显得很重要了,因为挖海、扩容是需要消耗大量的人力物力财力的。同样的道理,Collection的初始容量也显得异常重要。所以:对于已知的情景,请为集合指定初始容量。 public static void main(String[] args) {

StudentVO student = null;

long begin1 = System.currentTimeMillis();

List<StudentVO> list1 = new ArrayList<>();

for(int i = 0 ; i < 1000000; i++){

student = new StudentVO(i,"chenssy_"+i,i);

list1.add(student);

}

long end1 = System.currentTimeMillis();

System.out.println("list1 time:" + (end1 - begin1));

long begin2 = System.currentTimeMillis();

List<StudentVO> list2 = new ArrayList<>(1000000);

for(int i = 0 ; i < 1000000; i++){

student = new StudentVO(i,"chenssy_"+i,i);

list2.add(student);

}

long end2 = System.currentTimeMillis();

System.out.println("list2 time:" + (end2 - begin2));

}上面代码两个list都是插入1000000条数据,只不过list1没有没有申请初始化容量,而list2初始化容量1000000。那运行结果如下: list1 time:1638 list2 time:921 从上面的运行结果我们可以看出list2的速度是list1的两倍左右。在前面LZ就提过,ArrayList的扩容机制是比较消耗资源的。我们先看ArrayList的add方法: public boolean add(E e) {

ensureCapacity(size + 1);

elementData[size++] = e;

return true;

}

public void ensureCapacity(int minCapacity) {

modCount++; //修改计数器

int oldCapacity = elementData.length;

//当前需要的长度超过了数组长度,进行扩容处理

if (minCapacity > oldCapacity) {

Object oldData[] = elementData;

//新的容量 = 旧容量 * 1.5 + 1

int newCapacity = (oldCapacity * 3)/2 + 1;

if (newCapacity < minCapacity)

newCapacity = minCapacity;

//数组拷贝,生成新的数组

elementData = Arrays.copyOf(elementData, newCapacity);

}

}ArrayList每次新增一个元素,就会检测ArrayList的当前容量是否已经到达临界点,如果到达临界点则会扩容1.5倍。然而ArrayList的扩容以及数组的拷贝生成新的数组是相当耗资源的。所以若我们事先已知集合的使用场景,知道集合的大概范围,我们最好是指定初始化容量,这样对资源的利用会更加好,尤其是大数据量的前提下,效率的提升和资源的利用会显得更加具有优势。 >>>>>>java集合细节一:请为集合指定初始容量 -----原文出自:http://cmsblogs.com/?p=1233,请尊重作者辛勤劳动成果,转载说明出处. -----个人站点:http://cmsblogs.com

作者:chenssy 发表于2014/8/4 19:19:20 原文链接

阅读:4372 评论:0 查看评论

| ||||||||||||

| Java提高篇(三四)-----fail-fast机制 | ||||||||||||

|

在JDK的Collection中我们时常会看到类似于这样的话: 例如,ArrayList:

HashMap中:

在这两段话中反复地提到”快速失败”。那么何为”快速失败”机制呢? “快速失败”也就是fail-fast,它是Java集合的一种错误检测机制。当多个线程对集合进行结构上的改变的操作时,有可能会产生fail-fast机制。记住是有可能,而不是一定。例如:假设存在两个线程(线程1、线程2),线程1通过Iterator在遍历集合A中的元素,在某个时候线程2修改了集合A的结构(是结构上面的修改,而不是简单的修改集合元素的内容),那么这个时候程序就会抛出 ConcurrentModificationException 异常,从而产生fail-fast机制。 一、fail-fast示例public class FailFastTest {

private static List<Integer> list = new ArrayList<>();

/**

* @desc:线程one迭代list

* @Project:test

* @file:FailFastTest.java

* @Authro:chenssy

* @data:2014年7月26日

*/

private static class threadOne extends Thread{

public void run() {

Iterator<Integer> iterator = list.iterator();

while(iterator.hasNext()){

int i = iterator.next();

System.out.println("ThreadOne 遍历:" + i);

try {

Thread.sleep(10);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

}

/**

* @desc:当i == 3时,修改list

* @Project:test

* @file:FailFastTest.java

* @Authro:chenssy

* @data:2014年7月26日

*/

private static class threadTwo extends Thread{

public void run(){

int i = 0 ;

while(i < 6){

System.out.println("ThreadTwo run:" + i);

if(i == 3){

list.remove(i);

}

i++;

}

}

}

public static void main(String[] args) {

for(int i = 0 ; i < 10;i++){

list.add(i);

}

new threadOne().start();

new threadTwo().start();

}

} 运行结果: ThreadOne 遍历:0

ThreadTwo run:0

ThreadTwo run:1

ThreadTwo run:2

ThreadTwo run:3

ThreadTwo run:4

ThreadTwo run:5

Exception in thread "Thread-0" java.util.ConcurrentModificationException

at java.util.ArrayList$Itr.checkForComodification(Unknown Source)

at java.util.ArrayList$Itr.next(Unknown Source)

at test.ArrayListTest$threadOne.run(ArrayListTest.java:23)二、fail-fast产生原因通过上面的示例和讲解,我初步知道fail-fast产生的原因就在于程序在对 collection 进行迭代时,某个线程对该 collection 在结构上对其做了修改,这时迭代器就会抛出 ConcurrentModificationException 异常信息,从而产生 fail-fast。 要了解fail-fast机制,我们首先要对ConcurrentModificationException 异常有所了解。当方法检测到对象的并发修改,但不允许这种修改时就抛出该异常。同时需要注意的是,该异常不会始终指出对象已经由不同线程并发修改,如果单线程违反了规则,同样也有可能会抛出改异常。 诚然,迭代器的快速失败行为无法得到保证,它不能保证一定会出现该错误,但是快速失败操作会尽最大努力抛出ConcurrentModificationException异常,所以因此,为提高此类操作的正确性而编写一个依赖于此异常的程序是错误的做法,正确做法是:ConcurrentModificationException 应该仅用于检测 bug。下面我将以ArrayList为例进一步分析fail-fast产生的原因。 从前面我们知道fail-fast是在操作迭代器时产生的。现在我们来看看ArrayList中迭代器的源代码: private class Itr implements Iterator<E> {

int cursor;

int lastRet = -1;

int expectedModCount = ArrayList.this.modCount;

public boolean hasNext() {

return (this.cursor != ArrayList.this.size);

}

public E next() {

checkForComodification();

/** 省略此处代码 */

}

public void remove() {

if (this.lastRet < 0)

throw new IllegalStateException();

checkForComodification();

/** 省略此处代码 */

}

final void checkForComodification() {

if (ArrayList.this.modCount == this.expectedModCount)

return;

throw new ConcurrentModificationException();

}

}从上面的源代码我们可以看出,迭代器在调用next()、remove()方法时都是调用checkForComodification()方法,该方法主要就是检测modCount == expectedModCount ? 若不等则抛出ConcurrentModificationException 异常,从而产生fail-fast机制。所以要弄清楚为什么会产生fail-fast机制我们就必须要用弄明白为什么modCount != expectedModCount ,他们的值在什么时候发生改变的。 expectedModCount 是在Itr中定义的:int expectedModCount = ArrayList.this.modCount;所以他的值是不可能会修改的,所以会变的就是modCount。modCount是在 AbstractList 中定义的,为全局变量: protected transient int modCount = 0; 那么他什么时候因为什么原因而发生改变呢?请看ArrayList的源码: public boolean add(E paramE) {

ensureCapacityInternal(this.size + 1);

/** 省略此处代码 */

}

private void ensureCapacityInternal(int paramInt) {

if (this.elementData == EMPTY_ELEMENTDATA)

paramInt = Math.max(10, paramInt);

ensureExplicitCapacity(paramInt);

}

private void ensureExplicitCapacity(int paramInt) {

this.modCount += 1; //修改modCount

/** 省略此处代码 */

}

public boolean remove(Object paramObject) {

int i;

if (paramObject == null)

for (i = 0; i < this.size; ++i) {

if (this.elementData[i] != null)

continue;

fastRemove(i);

return true;

}

else

for (i = 0; i < this.size; ++i) {

if (!(paramObject.equals(this.elementData[i])))

continue;

fastRemove(i);

return true;

}

return false;

}

private void fastRemove(int paramInt) {

this.modCount += 1; //修改modCount

/** 省略此处代码 */

}

public void clear() {

this.modCount += 1; //修改modCount

/** 省略此处代码 */

}从上面的源代码我们可以看出,ArrayList中无论add、remove、clear方法只要是涉及了改变ArrayList元素的个数的方法都会导致modCount的改变。所以我们这里可以初步判断由于expectedModCount 得值与modCount的改变不同步,导致两者之间不等从而产生fail-fast机制。知道产生fail-fast产生的根本原因了,我们可以有如下场景: 有两个线程(线程A,线程B),其中线程A负责遍历list、线程B修改list。线程A在遍历list过程的某个时候(此时expectedModCount = modCount=N),线程启动,同时线程B增加一个元素,这是modCount的值发生改变(modCount + 1 = N + 1)。线程A继续遍历执行next方法时,通告checkForComodification方法发现expectedModCount = N ,而modCount = N + 1,两者不等,这时就抛出ConcurrentModificationException 异常,从而产生fail-fast机制。 所以,直到这里我们已经完全了解了fail-fast产生的根本原因了。知道了原因就好找解决办法了。 三、fail-fast解决办法通过前面的实例、源码分析,我想各位已经基本了解了fail-fast的机制,下面我就产生的原因提出解决方案。这里有两种解决方案: 方案一:在遍历过程中所有涉及到改变modCount值得地方全部加上synchronized或者直接使用Collections.synchronizedList,这样就可以解决。但是不推荐,因为增删造成的同步锁可能会阻塞遍历操作。 方案二:使用CopyOnWriteArrayList来替换ArrayList。推荐使用该方案。 CopyOnWriteArrayList为何物?ArrayList 的一个线程安全的变体,其中所有可变操作(add、set 等等)都是通过对底层数组进行一次新的复制来实现的。 该类产生的开销比较大,但是在两种情况下,它非常适合使用。1:在不能或不想进行同步遍历,但又需要从并发线程中排除冲突时。2:当遍历操作的数量大大超过可变操作的数量时。遇到这两种情况使用CopyOnWriteArrayList来替代ArrayList再适合不过了。那么为什么CopyOnWriterArrayList可以替代ArrayList呢? 第一、CopyOnWriterArrayList的无论是从数据结构、定义都和ArrayList一样。它和ArrayList一样,同样是实现List接口,底层使用数组实现。在方法上也包含add、remove、clear、iterator等方法。 第二、CopyOnWriterArrayList根本就不会产生ConcurrentModificationException异常,也就是它使用迭代器完全不会产生fail-fast机制。请看: private static class COWIterator<E> implements ListIterator<E> {

/** 省略此处代码 */

public E next() {

if (!(hasNext()))

throw new NoSuchElementException();

return this.snapshot[(this.cursor++)];

}

/** 省略此处代码 */

}CopyOnWriterArrayList的方法根本就没有像ArrayList中使用checkForComodification方法来判断expectedModCount 与 modCount 是否相等。它为什么会这么做,凭什么可以这么做呢?我们以add方法为例: public boolean add(E paramE) {

ReentrantLock localReentrantLock = this.lock;

localReentrantLock.lock();

try {

Object[] arrayOfObject1 = getArray();

int i = arrayOfObject1.length;

Object[] arrayOfObject2 = Arrays.copyOf(arrayOfObject1, i + 1);

arrayOfObject2[i] = paramE;

setArray(arrayOfObject2);

int j = 1;

return j;

} finally {

localReentrantLock.unlock();

}

}

final void setArray(Object[] paramArrayOfObject) {

this.array = paramArrayOfObject;

}CopyOnWriterArrayList的add方法与ArrayList的add方法有一个最大的不同点就在于,下面三句代码: Object[] arrayOfObject2 = Arrays.copyOf(arrayOfObject1, i + 1); arrayOfObject2[i] = paramE; setArray(arrayOfObject2); 就是这三句代码使得CopyOnWriterArrayList不会抛ConcurrentModificationException异常。他们所展现的魅力就在于copy原来的array,再在copy数组上进行add操作,这样做就完全不会影响COWIterator中的array了。 所以CopyOnWriterArrayList所代表的核心概念就是:任何对array在结构上有所改变的操作(add、remove、clear等),CopyOnWriterArrayList都会copy现有的数据,再在copy的数据上修改,这样就不会影响COWIterator中的数据了,修改完成之后改变原有数据的引用即可。同时这样造成的代价就是产生大量的对象,同时数组的copy也是相当有损耗的。 参考文档:http://www.cnblogs.com/skywang12345/p/3308762.html#a3

-----原文出自:http://cmsblogs.com/?p=1220,请尊重作者辛勤劳动成果,转载说明出处. -----个人站点:http://cmsblogs.com

作者:chenssy 发表于2014/7/26 22:40:44 原文链接

阅读:10927 评论:23 查看评论

| ||||||||||||

| Java提高篇(三三)-----Map总结 | ||||||||||||

|

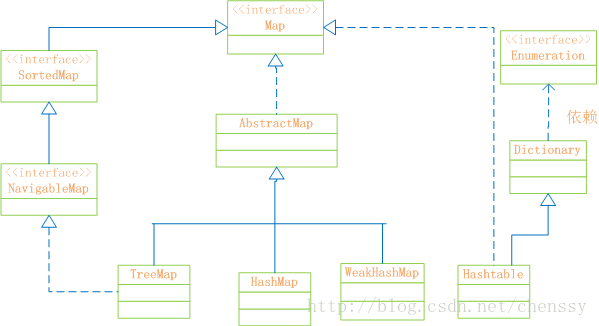

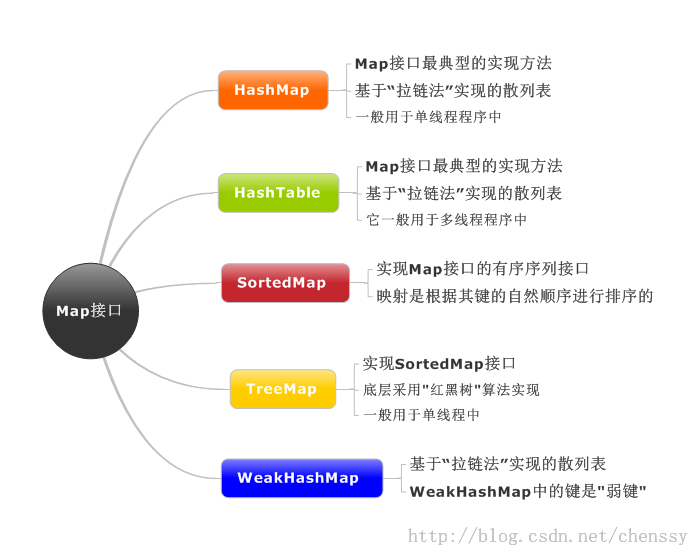

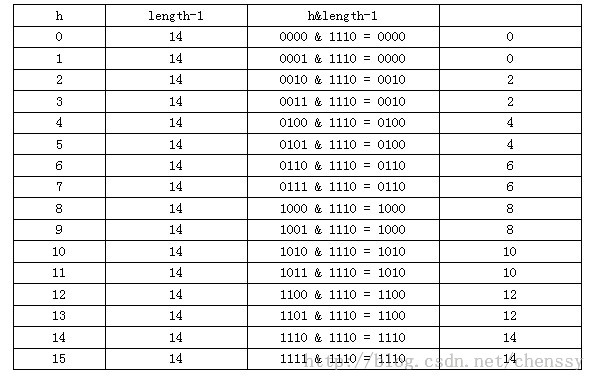

在前面LZ详细介绍了HashMap、HashTable、TreeMap的实现方法,从数据结构、实现原理、源码分析三个方面进行阐述,对这个三个类应该有了比较清晰的了解,下面LZ就Map做一个简单的总结。 推荐阅读: 一、Map概述首先先看Map的结构示意图

Map:“键值”对映射的抽象接口。该映射不包括重复的键,一个键对应一个值。 SortedMap:有序的键值对接口,继承Map接口。 NavigableMap:继承SortedMap,具有了针对给定搜索目标返回最接近匹配项的导航方法的接口。 AbstractMap:实现了Map中的绝大部分函数接口。它减少了“Map的实现类”的重复编码。 Dictionary:任何可将键映射到相应值的类的抽象父类。目前被Map接口取代。 TreeMap:有序散列表,实现SortedMap 接口,底层通过红黑树实现。 HashMap:是基于“拉链法”实现的散列表。底层采用“数组+链表”实现。 WeakHashMap:基于“拉链法”实现的散列表。 HashTable:基于“拉链法”实现的散列表。 总结如下:

他们之间的区别:

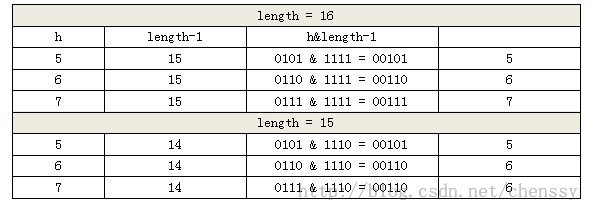

二、内部哈希: 哈希映射技术几乎所有通用Map都使用哈希映射技术。对于我们程序员来说我们必须要对其有所了解。 哈希映射技术是一种就元素映射到数组的非常简单的技术。由于哈希映射采用的是数组结果,那么必然存在一中用于确定任意键访问数组的索引机制,该机制能够提供一个小于数组大小的整数,我们将该机制称之为哈希函数。在Java中我们不必为寻找这样的整数而大伤脑筋,因为每个对象都必定存在一个返回整数值的hashCode方法,而我们需要做的就是将其转换为整数,然后再将该值除以数组大小取余即可。如下: int hashValue = Maths.abs(obj.hashCode()) % size;下面是HashMap、HashTable的: ----------HashMap------------

//计算hash值

static int hash(int h) {

h ^= (h >>> 20) ^ (h >>> 12);

return h ^ (h >>> 7) ^ (h >>> 4);

}

//计算key的索引位置

static int indexFor(int h, int length) {

return h & (length-1);

}

-----HashTable--------------

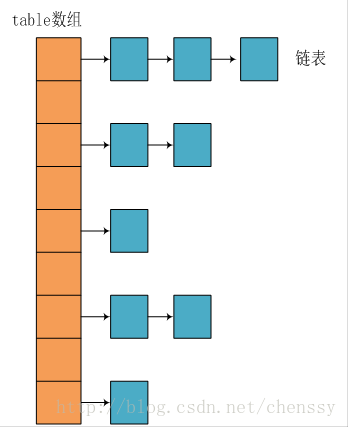

int index = (hash & 0x7FFFFFFF) % tab.length; //确认该key的索引位置位置的索引就代表了该节点在数组中的位置。下图是哈希映射的基本原理图:

public V put(K key, V value) {

//当key为null,调用putForNullKey方法,保存null与table第一个位置中,这是HashMap允许为null的原因

if (key == null)

return putForNullKey(value);

//计算key的hash值

int hash = hash(key.hashCode());

//计算key hash 值在 table 数组中的位置

int i = indexFor(hash, table.length);

//从i出开始迭代 e,判断是否存在相同的key

for (Entry<K, V> e = table[i]; e != null; e = e.next) {

Object k;

//判断该条链上是否有hash值相同的(key相同)

//若存在相同,则直接覆盖value,返回旧value

if (e.hash == hash && ((k = e.key) == key || key.equals(k))) {

V oldValue = e.value; //旧值 = 新值

e.value = value;

e.recordAccess(this);

return oldValue; //返回旧值

}

}

//修改次数增加1

modCount++;

//将key、value添加至i位置处

addEntry(hash, key, value, i);

return null;

}

HashMap的put方法展示了哈希映射的基本思想,其实如果我们查看其它的Map,发现其原理都差不多! 三、Map优化首先我们这样假设,假设哈希映射的内部数组的大小只有1,所有的元素都将映射该位置(0),从而构成一条较长的链表。由于我们更新、访问都要对这条链表进行线性搜索,这样势必会降低效率。我们假设,如果存在一个非常大数组,每个位置链表处都只有一个元素,在进行访问时计算其 index 值就会获得该对象,这样做虽然会提高我们搜索的效率,但是它浪费了控件。诚然,虽然这两种方式都是极端的,但是它给我们提供了一种优化思路:使用一个较大的数组让元素能够均匀分布。在Map有两个会影响到其效率,一是容器的初始化大小、二是负载因子。 3.1、调整实现大小在哈希映射表中,内部数组中的每个位置称作“存储桶”(bucket),而可用的存储桶数(即内部数组的大小)称作容量 (capacity),我们为了使Map对象能够有效地处理任意数的元素,将Map设计成可以调整自身的大小。我们知道当Map中的元素达到一定量的时候就会调整容器自身的大小,但是这个调整大小的过程其开销是非常大的。调整大小需要将原来所有的元素插入到新数组中。我们知道index = hash(key) % length。这样可能会导致原先冲突的键不在冲突,不冲突的键现在冲突的,重新计算、调整、插入的过程开销是非常大的,效率也比较低下。所以,如果我们开始知道Map的预期大小值,将Map调整的足够大,则可以大大减少甚至不需要重新调整大小,这很有可能会提高速度。下面是HashMap调整容器大小的过程,通过下面的代码我们可以看到其扩容过程的复杂性: void resize(int newCapacity) {

Entry[] oldTable = table; //原始容器

int oldCapacity = oldTable.length; //原始容器大小

if (oldCapacity == MAXIMUM_CAPACITY) { //是否超过最大值:1073741824

threshold = Integer.MAX_VALUE;

return;

}

//新的数组:大小为 oldCapacity * 2

Entry[] newTable = new Entry[newCapacity];

transfer(newTable, initHashSeedAsNeeded(newCapacity));

table = newTable;

/*

* 重新计算阀值 = newCapacity * loadFactor > MAXIMUM_CAPACITY + 1 ?

* newCapacity * loadFactor :MAXIMUM_CAPACITY + 1

*/

threshold = (int)Math.min(newCapacity * loadFactor, MAXIMUM_CAPACITY + 1);

}

//将元素插入到新数组中

void transfer(Entry[] newTable, boolean rehash) {

int newCapacity = newTable.length;

for (Entry<K,V> e : table) {

while(null != e) {

Entry<K,V> next = e.next;

if (rehash) {

e.hash = null == e.key ? 0 : hash(e.key);

}

int i = indexFor(e.hash, newCapacity);

e.next = newTable[i];

newTable[i] = e;

e = next;

}

}

}3.2、负载因子为了确认何时需要调整Map容器,Map使用了一个额外的参数并且粗略计算存储容器的密度。在Map调整大小之前,使用”负载因子”来指示Map将会承担的“负载量”,也就是它的负载程度,当容器中元素的数量达到了这个“负载量”,则Map将会进行扩容操作。负载因子、容量、Map大小之间的关系如下:负载因子 * 容量 > map大小 ----->调整Map大小。 例如:如果负载因子大小为0.75(HashMap的默认值),默认容量为11,则 11 * 0.75 = 8.25 = 8,所以当我们容器中插入第八个元素的时候,Map就会调整大小。 负载因子本身就是在控件和时间之间的折衷。当我使用较小的负载因子时,虽然降低了冲突的可能性,使得单个链表的长度减小了,加快了访问和更新的速度,但是它占用了更多的控件,使得数组中的大部分控件没有得到利用,元素分布比较稀疏,同时由于Map频繁的调整大小,可能会降低性能。但是如果负载因子过大,会使得元素分布比较紧凑,导致产生冲突的可能性加大,从而访问、更新速度较慢。所以我们一般推荐不更改负载因子的值,采用默认值0.75. 最后推荐阅读: java提高篇(二三)—–HashMap

-----原文出自:http://cmsblogs.com/?p=1212,请尊重作者辛勤劳动成果,转载说明出处. -----个人站点:http://cmsblogs.com

作者:chenssy 发表于2014/7/17 16:39:46 原文链接

阅读:4748 评论:3 查看评论

| ||||||||||||

| Java提高篇(三二)-----List总结 | ||||||||||||

|

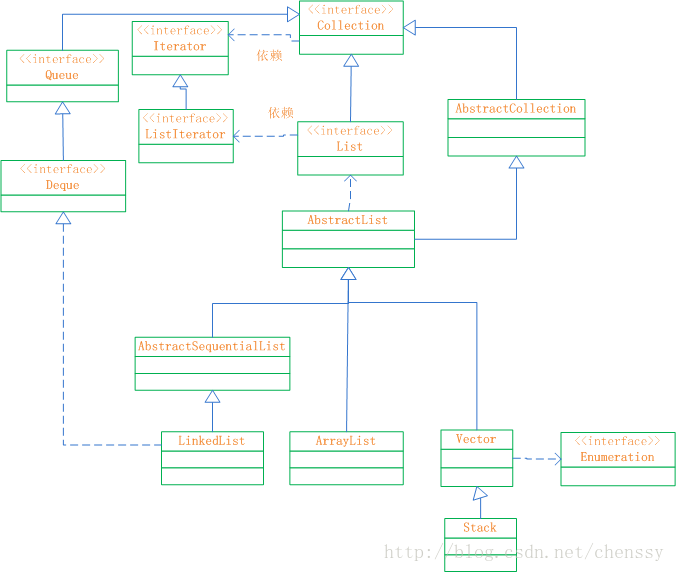

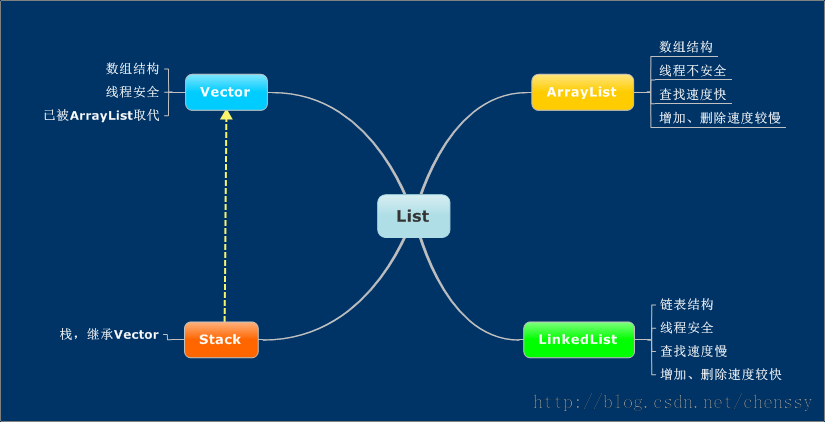

前面LZ已经充分介绍了有关于List接口的大部分知识,如ArrayList、LinkedList、Vector、Stack,通过这几个知识点可以对List接口有了比较深的了解了。只有通过归纳总结的知识才是你的知识。所以下面LZ就List接口做一个总结。推荐阅读: java提高篇(二一)-----ArrayList一、List接口概述 List接口,成为有序的Collection也就是序列。该接口可以对列表中的每一个元素的插入位置进行精确的控制,同时用户可以根据元素的整数索引(在列表中的位置)访问元素,并搜索列表中的元素。 下图是List接口的框架图:

通过上面的框架图,可以对List的结构了然于心,其各个类、接口如下: Collection:Collection 层次结构 中的根接口。它表示一组对象,这些对象也称为 collection 的元素。对于Collection而言,它不提供任何直接的实现,所有的实现全部由它的子类负责。 AbstractCollection:提供 Collection 接口的骨干实现,以最大限度地减少了实现此接口所需的工作。对于我们而言要实现一个不可修改的 collection,只需扩展此类,并提供 iterator 和 size 方法的实现。但要实现可修改的 collection,就必须另外重写此类的 add 方法(否则,会抛出 UnsupportedOperationException),iterator 方法返回的迭代器还必须另外实现其 remove 方法。 terator:迭代器。 ListIterator:系列表迭代器,允许程序员按任一方向遍历列表、迭代期间修改列表,并获得迭代器在列表中的当前位置。 List:继承于Collection的接口。它代表着有序的队列。 AbstractList:List 接口的骨干实现,以最大限度地减少实现“随机访问”数据存储(如数组)支持的该接口所需的工作。 Queue:队列。提供队列基本的插入、获取、检查操作。 Deque:一个线性 collection,支持在两端插入和移除元素。大多数 Deque 实现对于它们能够包含的元素数没有固定限制,但此接口既支持有容量限制的双端队列,也支持没有固定大小限制的双端队列。 AbstractSequentialList:提供了 List 接口的骨干实现,从而最大限度地减少了实现受“连续访问”数据存储(如链接列表)支持的此接口所需的工作。从某种意义上说,此类与在列表的列表迭代器上实现“随机访问”方法。 LinkedList:List 接口的链接列表实现。它实现所有可选的列表操作。 ArrayList:List 接口的大小可变数组的实现。它实现了所有可选列表操作,并允许包括 null 在内的所有元素。除了实现 List 接口外,此类还提供一些方法来操作内部用来存储列表的数组的大小。 Vector:实现可增长的对象数组。与数组一样,它包含可以使用整数索引进行访问的组件。 Stack:后进先出(LIFO)的对象堆栈。它通过五个操作对类 Vector 进行了扩展 ,允许将向量视为堆栈。 Enumeration:枚举,实现了该接口的对象,它生成一系列元素,一次生成一个。连续调用 nextElement 方法将返回一系列的连续元素。

二、使用场景学习知识的根本目的就是使用它。每个知识点都有它的使用范围。集合也是如此,在Java中集合的家族非常庞大,每个成员都有最适合的使用场景。在刚刚接触List时,LZ就说过如果涉及到“栈”、“队列”、“链表”等操作,请优先考虑用List。至于是那个List则分如下: 1、对于需要快速插入、删除元素,则需使用LinkedList。 2、对于需要快速访问元素,则需使用ArrayList。 3、对于“单线程环境”或者“多线程环境,但是List仅被一个线程操作”,需要考虑使用非同步的类,如果是“多线程环境,切List可能同时被多个线程操作”,考虑使用同步的类(如Vector)。 2.1ArrayList、LinkedList性能分析在List中我们使用最普遍的就是LinkedList和ArrayList,同时我们也了解了他们两者之间的使用场景和区别。 public class ListTest {

private static final int COUNT = 100000;

private static ArrayList arrayList = new ArrayList<>();

private static LinkedList linkedList = new LinkedList<>();

private static Vector vector = new Vector<>();

public static void insertToList(List list){

long startTime = System.currentTimeMillis();

for(int i = 0 ; i < COUNT ; i++){

list.add(0,i);

}

long endTime = System.currentTimeMillis();

System.out.println("插入 " + COUNT + "元素" + getName(list) + "花费 " + (endTime - startTime) + " 毫秒");

}

public static void deleteFromList(List list){

long startTime = System.currentTimeMillis();

for(int i = 0 ; i < COUNT ; i++){

list.remove(0);

}

long endTime = System.currentTimeMillis();

System.out.println("删除" + COUNT + "元素" + getName(list) + "花费 " + (endTime - startTime) + " 毫秒");

}

public static void readList(List list){

long startTime = System.currentTimeMillis();

for(int i = 0 ; i < COUNT ; i++){

list.get(i);

}

long endTime = System.currentTimeMillis();

System.out.println("读取" + COUNT + "元素" + getName(list) + "花费 " + (endTime - startTime) + " 毫秒");

}

private static String getName(List list) {

String name = "";

if(list instanceof ArrayList){

name = "ArrayList";

}

else if(list instanceof LinkedList){

name = "LinkedList";

}

else if(list instanceof Vector){

name = "Vector";

}

return name;

}

public static void main(String[] args) {

insertToList(arrayList);

insertToList(linkedList);

insertToList(vector);

System.out.println("--------------------------------------");

readList(arrayList);

readList(linkedList);

readList(vector);

System.out.println("--------------------------------------");

deleteFromList(arrayList);

deleteFromList(linkedList);

deleteFromList(vector);

}

}运行结果: 插入 100000元素ArrayList花费 3900 毫秒 插入 100000元素LinkedList花费 15 毫秒 插入 100000元素Vector花费 3933 毫秒 -------------------------------------- 读取100000元素ArrayList花费 0 毫秒 读取100000元素LinkedList花费 8877 毫秒 读取100000元素Vector花费 16 毫秒 -------------------------------------- 删除100000元素ArrayList花费 4618 毫秒 删除100000元素LinkedList花费 16 毫秒 删除100000元素Vector花费 4759 毫秒 从上面的运行结果我们可以清晰的看出ArrayList、LinkedList、Vector增加、删除、遍历的效率问题。下面我就插入方法add(int index, E element),delete、get方法各位如有兴趣可以研究研究。 首先我们先看三者之间的源码: ArrayList public void add(int index, E element) {

rangeCheckForAdd(index); //检查是否index是否合法

ensureCapacityInternal(size + 1); //扩容操作

System.arraycopy(elementData, index, elementData, index + 1, size - index); //数组拷贝

elementData[index] = element; //插入

size++;

}rangeCheckForAdd、ensureCapacityInternal两个方法没有什么影响,真正产生影响的是System.arraycopy方法,该方法是个JNI函数,是在JVM中实现的。声明如下: public static native void arraycopy(Object src, int srcPos, Object dest, int destPos, int length); 目前LZ无法看到源码,具体的实现不是很清楚,不过System.arraycopy源码分析对其进行了比较清晰的分析。但事实上我们只需要了解该方法会移动index后面的所有元素即可,这就意味着ArrayList的add(int index, E element)方法会引起index位置之后所有元素的改变,这真是牵一处而动全身。 LinkedList public void add(int index, E element) {

checkPositionIndex(index);

if (index == size) //插入位置在末尾

linkLast(element);

else

linkBefore(element, node(index));

}该方法比较简单,插入位置在末尾则调用linkLast方法,否则调用linkBefore方法,其实linkLast、linkBefore都是非常简单的实现,就是在index位置插入元素,至于index具体为知则有node方法来解决,同时node对index位置检索还有一个加速作用,如下: Node<E> node(int index) {

if (index < (size >> 1)) { //如果index 小于 size/2 则从头开始查找

Node<E> x = first;

for (int i = 0; i < index; i++)

x = x.next;

return x;

} else { //如果index 大于 size/2 则从尾部开始查找

Node<E> x = last;

for (int i = size - 1; i > index; i--)

x = x.prev;

return x;

}

}所以linkedList的插入动作比ArrayList动作快就在于两个方面。1:linkedList不需要执行元素拷贝动作,没有牵一发而动全身的大动作。2:查找插入位置有加速动作即:若index < 双向链表长度的1/2,则从前向后查找; 否则,从后向前查找。 Vector Vector的实现机制和ArrayList一样,同样是使用动态数组来实现的,所以他们两者之间的效率差不多,add的源码也一样,如下: public void add(int index, E element) {

insertElementAt(element, index);

}

public synchronized void insertElementAt(E obj, int index) {

modCount++;

if (index > elementCount) {

throw new ArrayIndexOutOfBoundsException(index

+ " > " + elementCount);

}

ensureCapacityHelper(elementCount + 1);

System.arraycopy(elementData, index, elementData, index + 1, elementCount - index);

elementData[index] = obj;

elementCount++;

}上面是针对ArrayList、LinkedList、Vector三者之间的add(int index,E element)方法的解释,解释了LinkedList的插入动作要比ArrayList、Vector的插入动作效率为什么要高出这么多!至于delete、get两个方法LZ就不多解释了。 同时LZ在写上面那个例子时发现了一个非常有趣的现象,就是linkedList在某些时候执行add方法时比ArrayList方法会更慢!至于在什么情况?为什么会慢LZ下篇博客解释,当然不知道这个情况各位是否也遇到过?? 2.2、Vector和ArrayList的区别

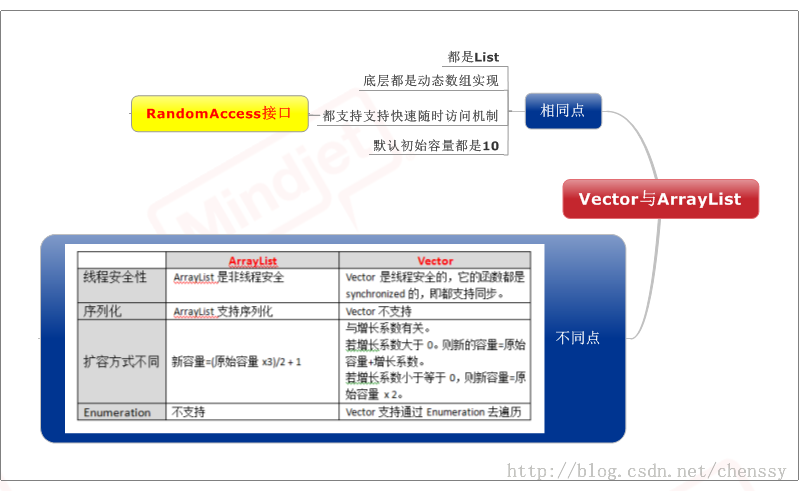

四、更多-----原文出自:http://cmsblogs.com/?p=1201,请尊重作者辛勤劳动成果,转载说明出处. -----个人站点:http://cmsblogs.com

作者:chenssy 发表于2014/7/14 10:18:13 原文链接

阅读:2913 评论:3 查看评论

| ||||||||||||

| Java提高篇(三一)-----Stack | ||||||||||||

|

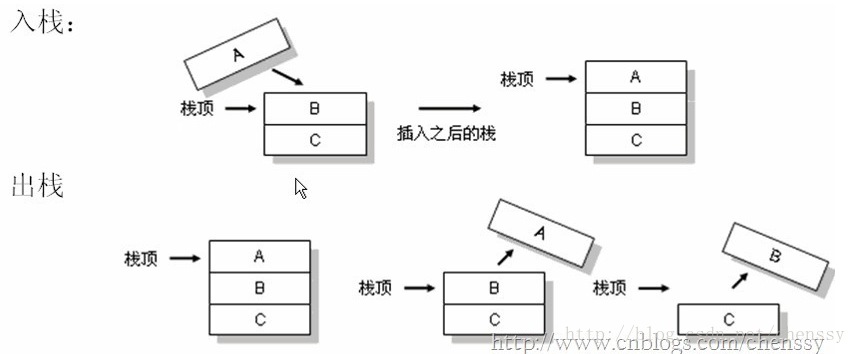

在Java中Stack类表示后进先出(LIFO)的对象堆栈。栈是一种非常常见的数据结构,它采用典型的先进后出的操作方式完成的。每一个栈都包含一个栈顶,每次出栈是将栈顶的数据取出,如下:

Stack通过五个操作对Vector进行扩展,允许将向量视为堆栈。这个五个操作如下:

Stack继承Vector,他对Vector进行了简单的扩展: public class Stack<E> extends Vector<E> Stack的实现非常简单,仅有一个构造方法,五个实现方法(从Vector继承而来的方法不算与其中),同时其实现的源码非常简单 /**

* 构造函数

*/

public Stack() {

}

/**

* push函数:将元素存入栈顶

*/

public E push(E item) {

// 将元素存入栈顶。

// addElement()的实现在Vector.java中

addElement(item);

return item;

}

/**

* pop函数:返回栈顶元素,并将其从栈中删除

*/

public synchronized E pop() {

E obj;

int len = size();

obj = peek();

// 删除栈顶元素,removeElementAt()的实现在Vector.java中

removeElementAt(len - 1);

return obj;

}

/**

* peek函数:返回栈顶元素,不执行删除操作

*/

public synchronized E peek() {

int len = size();

if (len == 0)

throw new EmptyStackException();

// 返回栈顶元素,elementAt()具体实现在Vector.java中

return elementAt(len - 1);

}

/**

* 栈是否为空

*/

public boolean empty() {

return size() == 0;

}

/**

* 查找“元素o”在栈中的位置:由栈底向栈顶方向数

*/

public synchronized int search(Object o) {

// 获取元素索引,elementAt()具体实现在Vector.java中

int i = lastIndexOf(o);

if (i >= 0) {

return size() - i;

}

return -1;

}Stack的源码很多都是基于Vector,所以这里不再累述,更多详情请参考:Java提高篇(二九)-----Vector

作者:chenssy 发表于2014/7/14 10:11:21 原文链接

阅读:3574 评论:1 查看评论

| ||||||||||||

| java提高篇(三十)-----Iterator | ||||||||||||

|

迭代对于我们搞Java的来说绝对不陌生。我们常常使用JDK提供的迭代接口进行Java集合的迭代。 Iterator iterator = list.iterator();

while(iterator.hasNext()){

String string = iterator.next();

//do something

}迭代其实我们可以简单地理解为遍历,是一个标准化遍历各类容器里面的所有对象的方法类,它是一个很典型的设计模式。Iterator模式是用于遍历集合类的标准访问方法。它可以把访问逻辑从不同类型的集合类中抽象出来,从而避免向客户端暴露集合的内部结构。 在没有迭代器时我们都是这么进行处理的。如下: 对于数组我们是使用下标来进行处理的: int[] arrays = new int[10];

for(int i = 0 ; i < arrays.length ; i++){

int a = arrays[i];

//do something

}对于ArrayList是这么处理的: List<String> list = new ArrayList<String>();

for(int i = 0 ; i < list.size() ; i++){

String string = list.get(i);

//do something

}对于这两种方式,我们总是都事先知道集合的内部结构,访问代码和集合本身是紧密耦合的,无法将访问逻辑从集合类和客户端代码中分离出来。同时每一种集合对应一种遍历方法,客户端代码无法复用。 在实际应用中如何需要将上面将两个集合进行整合是相当麻烦的。所以为了解决以上问题,Iterator模式腾空出世,它总是用同一种逻辑来遍历集合。使得客户端自身不需要来维护集合的内部结构,所有的内部状态都由Iterator来维护。客户端从不直接和集合类打交道,它总是控制Iterator,向它发送"向前","向后","取当前元素"的命令,就可以间接遍历整个集合。 上面只是对Iterator模式进行简单的说明,下面我们看看Java中Iterator接口,看他是如何来进行实现的。 一、java.util.Iterator在Java中Iterator为一个接口,它只提供了迭代了基本规则,在JDK中他是这样定义的:对 collection 进行迭代的迭代器。迭代器取代了 Java Collections Framework 中的 Enumeration。迭代器与枚举有两点不同: 1、迭代器允许调用者利用定义良好的语义在迭代期间从迭代器所指向的 collection 移除元素。 2、方法名称得到了改进。 其接口定义如下: public interface Iterator {

boolean hasNext();

Object next();

void remove();

}其中: Object next():返回迭代器刚越过的元素的引用,返回值是Object,需要强制转换成自己需要的类型 boolean hasNext():判断容器内是否还有可供访问的元素 void remove():删除迭代器刚越过的元素 对于我们而言,我们只一般只需使用next()、hasNext()两个方法即可完成迭代。如下: for(Iterator it = c.iterator(); it.hasNext(); ) {

Object o = it.next();

//do something

}前面阐述了Iterator有一个很大的优点,就是我们不必知道集合的内部结果,集合的内部结构、状态由Iterator来维持,通过统一的方法hasNext()、next()来判断、获取下一个元素,至于具体的内部实现我们就不用关心了。但是作为一个合格的程序员我们非常有必要来弄清楚Iterator的实现。下面就ArrayList的源码进行分析分析。 二、各个集合的Iterator的实现下面就ArrayList的Iterator实现来分析,其实如果我们理解了ArrayList、Hashset、TreeSet的数据结构,内部实现,对于他们是如何实现Iterator也会胸有成竹的。因为ArrayList的内部实现采用数组,所以我们只需要记录相应位置的索引即可,其方法的实现比较简单。 2.1、ArrayList的Iterator实现在ArrayList内部首先是定义一个内部类Itr,该内部类实现Iterator接口,如下: private class Itr implements Iterator<E> {

//do something

}而ArrayList的iterator()方法实现: public Iterator<E> iterator() {

return new Itr();

}所以通过使用ArrayList.iterator()方法返回的是Itr()内部类,所以现在我们需要关心的就是Itr()内部类的实现: 在Itr内部定义了三个int型的变量:cursor、lastRet、expectedModCount。其中cursor表示下一个元素的索引位置,lastRet表示上一个元素的索引位置 int cursor; int lastRet = -1; int expectedModCount = modCount; 从cursor、lastRet定义可以看出,lastRet一直比cursor少一所以hasNext()实现方法异常简单,只需要判断cursor和lastRet是否相等即可。 public boolean hasNext() {

return cursor != size;

}对于next()实现其实也是比较简单的,只要返回cursor索引位置处的元素即可,然后修改cursor、lastRet即可, public E next() {

checkForComodification();

int i = cursor; //记录索引位置

if (i >= size) //如果获取元素大于集合元素个数,则抛出异常

throw new NoSuchElementException();

Object[] elementData = ArrayList.this.elementData;

if (i >= elementData.length)

throw new ConcurrentModificationException();

cursor = i + 1; //cursor + 1

return (E) elementData[lastRet = i]; //lastRet + 1 且返回cursor处元素

}checkForComodification()主要用来判断集合的修改次数是否合法,即用来判断遍历过程中集合是否被修改过。在java提高篇(二一)-----ArrayList中已经阐述了。modCount用于记录ArrayList集合的修改次数,初始化为0,,每当集合被修改一次(结构上面的修改,内部update不算),如add、remove等方法,modCount + 1,所以如果modCount不变,则表示集合内容没有被修改。该机制主要是用于实现ArrayList集合的快速失败机制,在Java的集合中,较大一部分集合是存在快速失败机制的,这里就不多说,后面会讲到。所以要保证在遍历过程中不出错误,我们就应该保证在遍历过程中不会对集合产生结构上的修改(当然remove方法除外),出现了异常错误,我们就应该认真检查程序是否出错而不是catch后不做处理。 final void checkForComodification() {

if (modCount != expectedModCount)

throw new ConcurrentModificationException();

}对于remove()方法的是实现,它是调用ArrayList本身的remove()方法删除lastRet位置元素,然后修改modCount即可。 public void remove() {

if (lastRet < 0)

throw new IllegalStateException();

checkForComodification();

try {

ArrayList.this.remove(lastRet);

cursor = lastRet;

lastRet = -1;

expectedModCount = modCount;

} catch (IndexOutOfBoundsException ex) {

throw new ConcurrentModificationException();

}

}这里就对ArrayList的Iterator实现讲解到这里,对于Hashset、TreeSet等集合的Iterator实现,各位如果感兴趣可以继续研究,个人认为在研究这些集合的源码之前,有必要对该集合的数据结构有清晰的认识,这样会达到事半功倍的效果!!!! —————————————————————————————————————————————————————————

作者:chenssy 发表于2014/7/7 17:33:47 原文链接

阅读:18407 评论:6 查看评论

| ||||||||||||

| java提高篇(二九)-----Vector | ||||||||||||

|

在java提高篇(二一)—–ArrayList、java提高篇(二二)—LinkedList,详细讲解了ArrayList、linkedList的原理和实现过程,对于List接口这里还介绍一个它的实现类Vector,Vector 类可以实现可增长的对象数组。 一、Vector简介Vector可以实现可增长的对象数组。与数组一样,它包含可以使用整数索引进行访问的组件。不过,Vector的大小是可以增加或者减小的,以便适应创建Vector后进行添加或者删除操作。 Vector实现List接口,继承AbstractList类,所以我们可以将其看做队列,支持相关的添加、删除、修改、遍历等功能。 Vector实现RandmoAccess接口,即提供了随机访问功能,提供提供快速访问功能。在Vector我们可以直接访问元素。 Vector 实现了Cloneable接口,支持clone()方法,可以被克隆。 public class Vector<E>

extends AbstractList<E>

implements List<E>, RandomAccess, Cloneable, java.io.SerializableVector提供了四个构造函数: /**

* 构造一个空向量,使其内部数据数组的大小为 10,其标准容量增量为零。

*/

public Vector() {

this(10);

}

/**

* 构造一个包含指定 collection 中的元素的向量,这些元素按其 collection 的迭代器返回元素的顺序排列。

*/

public Vector(Collection<? extends E> c) {

elementData = c.toArray();

elementCount = elementData.length;

// c.toArray might (incorrectly) not return Object[] (see 6260652)

if (elementData.getClass() != Object[].class)

elementData = Arrays.copyOf(elementData, elementCount,

Object[].class);

}

/**

* 使用指定的初始容量和等于零的容量增量构造一个空向量。

*/

public Vector(int initialCapacity) {

this(initialCapacity, 0);

}

/**

* 使用指定的初始容量和容量增量构造一个空的向量。

*/

public Vector(int initialCapacity, int capacityIncrement) {

super();

if (initialCapacity < 0)

throw new IllegalArgumentException("Illegal Capacity: "+

initialCapacity);

this.elementData = new Object[initialCapacity];

this.capacityIncrement = capacityIncrement;

}在成员变量方面,Vector提供了elementData , elementCount, capacityIncrement三个成员变量。其中 elementData :"Object[]类型的数组",它保存了Vector中的元素。按照Vector的设计elementData为一个动态数组,可以随着元素的增加而动态的增长,其具体的增加方式后面提到(ensureCapacity方法)。如果在初始化Vector时没有指定容器大小,则使用默认大小为10. elementCount: capacityIncrement:向量的大小大于其容量时,容量自动增加的量。如果在创建Vector时,指定了capacityIncrement的大小;则,每次当Vector中动态数组容量增加时>,增加的大小都是capacityIncrement。如果容量的增量小于等于零,则每次需要增大容量时,向量的容量将增大一倍。 同时Vector是线程安全的! 二、源码解析对于源码的解析,LZ在这里只就增加(add)删除(remove)两个方法进行讲解。 2.1增加:add(E e)add(E e):将指定元素添加到此向量的末尾。 public synchronized boolean add(E e) {

modCount++;

ensureCapacityHelper(elementCount + 1); //确认容器大小,如果操作容量则扩容操作

elementData[elementCount++] = e; //将e元素添加至末尾

return true;

}这个方法相对而言比较简单,具体过程就是先确认容器的大小,看是否需要进行扩容操作,然后将E元素添加到此向量的末尾。 private void ensureCapacityHelper(int minCapacity) {

//如果

if (minCapacity - elementData.length > 0)

grow(minCapacity);

}

/**

* 进行扩容操作

* 如果此向量的当前容量小于minCapacity,则通过将其内部数组替换为一个较大的数组俩增加其容量。

* 新数据数组的大小姜维原来的大小 + capacityIncrement,

* 除非 capacityIncrement 的值小于等于零,在后一种情况下,新的容量将为原来容量的两倍,不过,如果此大小仍然小于 minCapacity,则新容量将为 minCapacity。

*/

private void grow(int minCapacity) {

int oldCapacity = elementData.length; //当前容器大小

/*

* 新容器大小

* 若容量增量系数(capacityIncrement) > 0,则将容器大小增加到capacityIncrement

* 否则将容量增加一倍

*/

int newCapacity = oldCapacity + ((capacityIncrement > 0) ?

capacityIncrement : oldCapacity);

if (newCapacity - minCapacity < 0)

newCapacity = minCapacity;

if (newCapacity - MAX_ARRAY_SIZE > 0)

newCapacity = hugeCapacity(minCapacity);

elementData = Arrays.copyOf(elementData, newCapacity);

}

/**

* 判断是否超出最大范围

* MAX_ARRAY_SIZE:private static final int MAX_ARRAY_SIZE = Integer.MAX_VALUE - 8;

*/

private static int hugeCapacity(int minCapacity) {

if (minCapacity < 0)

throw new OutOfMemoryError();

return (minCapacity > MAX_ARRAY_SIZE) ? Integer.MAX_VALUE : MAX_ARRAY_SIZE;

}对于Vector整个的扩容过程,就是根据capacityIncrement确认扩容大小的,若capacityIncrement <= 0 则扩大一倍,否则扩大至capacityIncrement 。当然这个容量的最大范围为Integer.MAX_VALUE即,2^32 - 1,所以Vector并不是可以无限扩充的。 2.2、remove(Object o)/**

* 从Vector容器中移除指定元素E

*/

public boolean remove(Object o) {

return removeElement(o);

}

public synchronized boolean removeElement(Object obj) {

modCount++;

int i = indexOf(obj); //计算obj在Vector容器中位置

if (i >= 0) {

removeElementAt(i); //移除

return true;

}

return false;

}

public synchronized void removeElementAt(int index) {

modCount++; //修改次数+1

if (index >= elementCount) { //删除位置大于容器有效大小

throw new ArrayIndexOutOfBoundsException(index + " >= " + elementCount);

}

else if (index < 0) { //位置小于 < 0

throw new ArrayIndexOutOfBoundsException(index);

}

int j = elementCount - index - 1;

if (j > 0) {

//从指定源数组中复制一个数组,复制从指定的位置开始,到目标数组的指定位置结束。

//也就是数组元素从j位置往前移

System.arraycopy(elementData, index + 1, elementData, index, j);

}

elementCount--; //容器中有效组件个数 - 1

elementData[elementCount] = null; //将向量的末尾位置设置为null

}因为Vector底层是使用数组实现的,所以它的操作都是对数组进行操作,只不过其是可以随着元素的增加而动态的改变容量大小,其实现方法是是使用Arrays.copyOf方法将旧数据拷贝到一个新的大容量数组中。Vector的整个内部实现都比较简单,这里就不在重述了。 三、Vector遍历Vector支持4种遍历方式。 3.1、随机访问因为Vector实现了RandmoAccess接口,可以通过下标来进行随机访问。 for(int i = 0 ; i < vec.size() ; i++){

value = vec.get(i);

}3.2、迭代器Iterator it = vec.iterator();

while(it.hasNext()){

value = it.next();

//do something

}3.2、for循环for(Integer value:vec){

//do something

}3.4、Enumeration循环Vector vec = new Vector<>();

Enumeration enu = vec.elements();

while (enu.hasMoreElements()) {

value = (Integer)enu.nextElement();

}——————————————————————————————————————————————————————————————————————————-- 原文出自:http://cmsblogs.com/?p=1180。尊重作者的成果,转载请注明出处! -- 个人站点:http://cmsblogs.com

作者:chenssy 发表于2014/7/7 17:08:13 原文链接

阅读:4288 评论:2 查看评论

| ||||||||||||

| Java提高篇(二八)------TreeSet | ||||||||||||

|

与HashSet是基于HashMap实现一样,TreeSet同样是基于TreeMap实现的。在《Java提高篇(二七)-----TreeMap》中LZ详细讲解了TreeMap实现机制,如果客官详情看了这篇博文或者多TreeMap有比较详细的了解,那么TreeSet的实现对您是喝口水那么简单。 一、TreeSet定义我们知道TreeMap是一个有序的二叉树,那么同理TreeSet同样也是一个有序的,它的作用是提供有序的Set集合。通过源码我们知道TreeSet基础AbstractSet,实现NavigableSet、Cloneable、Serializable接口。其中AbstractSet提供 Set 接口的骨干实现,从而最大限度地减少了实现此接口所需的工作。NavigableSet是扩展的 public class TreeSet<E> extends AbstractSet<E> implements NavigableSet<E>, Cloneable, java.io.Serializable 同时在TreeSet中定义了如下几个变量。 private transient NavigableMap<E,Object> m; //PRESENT会被当做Map的value与key构建成键值对 private static final Object PRESENT = new Object(); 其构造方法: //默认构造方法,根据其元素的自然顺序进行排序 public TreeSet() { this(new TreeMap<E,Object>()); } //构造一个包含指定 collection 元素的新 TreeSet,它按照其元素的自然顺序进行排序。 public TreeSet(Comparator<? super E> comparator) { this(new TreeMap<>(comparator)); } //构造一个新的空 TreeSet,它根据指定比较器进行排序。 public TreeSet(Collection<? extends E> c) { this(); addAll(c); } //构造一个与指定有序 set 具有相同映射关系和相同排序的新 TreeSet。 public TreeSet(SortedSet<E> s) { this(s.comparator()); addAll(s); } TreeSet(NavigableMap<E,Object> m) { this.m = m; } 二、TreeSet主要方法1、add:将指定的元素添加到此 set(如果该元素尚未存在于 set 中)。 public boolean add(E e) { return m.put(e, PRESENT)==null; } 2、addAll:将指定 collection 中的所有元素添加到此 set 中。 public boolean addAll(Collection<? extends E> c) { // Use linear-time version if applicable if (m.size()==0 && c.size() > 0 && c instanceof SortedSet && m instanceof TreeMap) { SortedSet<? extends E> set = (SortedSet<? extends E>) c; TreeMap<E,Object> map = (TreeMap<E, Object>) m; Comparator<? super E> cc = (Comparator<? super E>) set.comparator(); Comparator<? super E> mc = map.comparator(); if (cc==mc || (cc != null && cc.equals(mc))) { map.addAllForTreeSet(set, PRESENT); return true; } } return super.addAll(c); } 3、ceiling:返回此 set 中大于等于给定元素的最小元素;如果不存在这样的元素,则返回 null。 public E ceiling(E e) { return m.ceilingKey(e); } 4、clear:移除此 set 中的所有元素。 public void clear() { m.clear(); } 5、clone:返回 TreeSet 实例的浅表副本。属于浅拷贝。 public Object clone() { TreeSet<E> clone = null; try { clone = (TreeSet<E>) super.clone(); } catch (CloneNotSupportedException e) { throw new InternalError(); } clone.m = new TreeMap<>(m); return clone; } 6、comparator:返回对此 set 中的元素进行排序的比较器;如果此 set 使用其元素的自然顺序,则返回 null。 public Comparator<? super E> comparator() { return m.comparator(); } 7、contains:如果此 set 包含指定的元素,则返回 true。 public boolean contains(Object o) { return m.containsKey(o); } 8、descendingIterator:返回在此 set 元素上按降序进行迭代的迭代器。 public Iterator<E> descendingIterator() { return m.descendingKeySet().iterator(); } 9、descendingSet:返回此 set 中所包含元素的逆序视图。 public NavigableSet<E> descendingSet() { return new TreeSet<>(m.descendingMap()); } 10、first:返回此 set 中当前第一个(最低)元素。 public E first() { return m.firstKey(); } 11、floor:返回此 set 中小于等于给定元素的最大元素;如果不存在这样的元素,则返回 null。 public E floor(E e) { return m.floorKey(e); } 12、headSet:返回此 set 的部分视图,其元素严格小于 toElement。 public SortedSet<E> headSet(E toElement) { return headSet(toElement, false); } 13、higher:返回此 set 中严格大于给定元素的最小元素;如果不存在这样的元素,则返回 null。 public E higher(E e) { return m.higherKey(e); } 14、isEmpty:如果此 set 不包含任何元素,则返回 true。 public boolean isEmpty() { return m.isEmpty(); } 15、iterator:返回在此 set 中的元素上按升序进行迭代的迭代器。 public Iterator<E> iterator() { return m.navigableKeySet().iterator(); } 16、last:返回此 set 中当前最后一个(最高)元素。 public E last() { return m.lastKey(); } 17、lower:返回此 set 中严格小于给定元素的最大元素;如果不存在这样的元素,则返回 null。 public E lower(E e) { return m.lowerKey(e); } 18、pollFirst:获取并移除第一个(最低)元素;如果此 set 为空,则返回 null。 public E pollFirst() { Map.Entry<E,?> e = m.pollFirstEntry(); return (e == null) ? null : e.getKey(); } 19、pollLast:获取并移除最后一个(最高)元素;如果此 set 为空,则返回 null。 public E pollLast() { Map.Entry<E,?> e = m.pollLastEntry(); return (e == null) ? null : e.getKey(); } 20、remove:将指定的元素从 set 中移除(如果该元素存在于此 set 中)。 public boolean remove(Object o) { return m.remove(o)==PRESENT; } 21、size:返回 set 中的元素数(set 的容量)。 public int size() { return m.size(); } 22、subSet:返回此 set 的部分视图 /** * 返回此 set 的部分视图,其元素范围从 fromElement 到 toElement。 */ public NavigableSet<E> subSet(E fromElement, boolean fromInclusive, E toElement, boolean toInclusive) { return new TreeSet<>(m.subMap(fromElement, fromInclusive, toElement, toInclusive)); } /** * 返回此 set 的部分视图,其元素从 fromElement(包括)到 toElement(不包括)。 */ public SortedSet<E> subSet(E fromElement, E toElement) { return subSet(fromElement, true, toElement, false); } 23、tailSet:返回此 set 的部分视图 /** * 返回此 set 的部分视图,其元素大于(或等于,如果 inclusive 为 true)fromElement。 */ public NavigableSet<E> tailSet(E fromElement, boolean inclusive) { return new TreeSet<>(m.tailMap(fromElement, inclusive)); } /** * 返回此 set 的部分视图,其元素大于等于 fromElement。 */ public SortedSet<E> tailSet(E fromElement) { return tailSet(fromElement, true); } 三、最后由于TreeSet是基于TreeMap实现的,所以如果我们对treeMap有了一定的了解,对TreeSet那是小菜一碟,我们从TreeSet中的源码可以看出,其实现过程非常简单,几乎所有的方法实现全部都是基于TreeMap的。

作者:chenssy 发表于2014/6/7 19:03:01 原文链接

阅读:2052 评论:0 查看评论

| ||||||||||||

| Java提高篇(二七)-----TreeMap | ||||||||||||

|

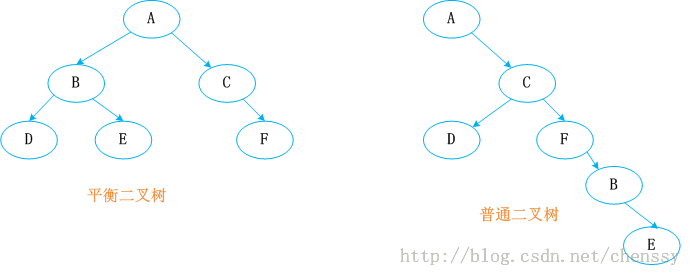

原文出自:http://cmsblogs.com/?p=1013。尊重作者的成果,转载请注明出处! 个人站点:http://cmsblogs.com ----------------------------------------------------------------------------------------------------------------------------------------------------------------------------TreeMap的实现是红黑树算法的实现,所以要了解TreeMap就必须对红黑树有一定的了解,其实这篇博文的名字叫做:根据红黑树的算法来分析TreeMap的实现,但是为了与Java提高篇系列博文保持一致还是叫做TreeMap比较好。通过这篇博文你可以获得如下知识点: 1、红黑树的基本概念。 2、红黑树增加节点、删除节点的实现过程。 3、红黑树左旋转、右旋转的复杂过程。 4、Java 中TreeMap是如何通过put、deleteEntry两个来实现红黑树增加、删除节点的。 我想通过这篇博文你对TreeMap一定有了更深的认识。好了,下面先简单普及红黑树知识。 一、红黑树简介红黑树又称红-黑二叉树,它首先是一颗二叉树,它具体二叉树所有的特性。同时红黑树更是一颗自平衡的排序二叉树。 我们知道一颗基本的二叉树他们都需要满足一个基本性质--即树中的任何节点的值大于它的左子节点,且小于它的右子节点。按照这个基本性质使得树的检索效率大大提高。我们知道在生成二叉树的过程是非常容易失衡的,最坏的情况就是一边倒(只有右/左子树),这样势必会导致二叉树的检索效率大大降低(O(n)),所以为了维持二叉树的平衡,大牛们提出了各种实现的算法,如:AVL,SBT,伸展树,TREAP ,红黑树等等。 平衡二叉树必须具备如下特性:它是一棵空树或它的左右两个子树的高度差的绝对值不超过1,并且左右两个子树都是一棵平衡二叉树。也就是说该二叉树的任何一个等等子节点,其左右子树的高度都相近。

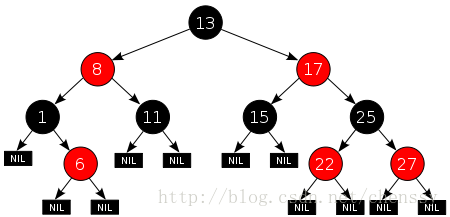

红黑树顾名思义就是节点是红色或者黑色的平衡二叉树,它通过颜色的约束来维持着二叉树的平衡。对于一棵有效的红黑树二叉树而言我们必须增加如下规则: 1、每个节点都只能是红色或者黑色 2、根节点是黑色 3、每个叶节点(NIL节点,空节点)是黑色的。 4、如果一个结点是红的,则它两个子节点都是黑的。也就是说在一条路径上不能出现相邻的两个红色结点。 5、从任一节点到其每个叶子的所有路径都包含相同数目的黑色节点。 这些约束强制了红黑树的关键性质: 从根到叶子的最长的可能路径不多于最短的可能路径的两倍长。结果是这棵树大致上是平衡的。因为操作比如插入、删除和查找某个值的最坏情况时间都要求与树的高度成比例,这个在高度上的理论上限允许红黑树在最坏情况下都是高效的,而不同于普通的二叉查找树。所以红黑树它是复杂而高效的,其检索效率O(log n)。下图为一颗典型的红黑二叉树。

对于红黑二叉树而言它主要包括三大基本操作:左旋、右旋、着色。

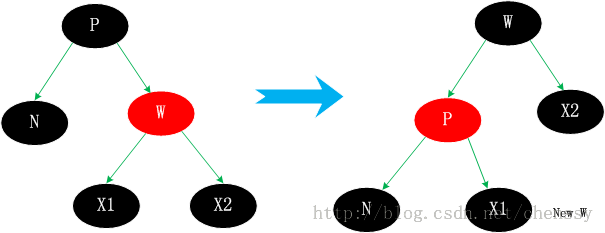

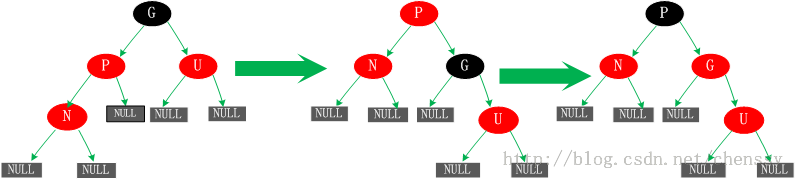

左旋 右旋 (图片来自:http://www.cnblogs.com/yangecnu/p/Introduce-Red-Black-Tree.html) 本节参考文献:http://baike.baidu.com/view/133754.htm?fr=aladdin-----百度百科 注:由于本文主要是讲解Java中TreeMap,所以并没有对红黑树进行非常深入的了解和研究,如果诸位想对其进行更加深入的研究Lz提供几篇较好的博文: 1、红黑树系列集锦 3、红黑树 二、TreeMap数据结构>>>>>>回归主角:TreeMap<<<<<< TreeMap的定义如下: public class TreeMap<K,V> extends AbstractMap<K,V> implements NavigableMap<K,V>, Cloneable, java.io.Serializable TreeMap继承AbstractMap,实现NavigableMap、Cloneable、Serializable三个接口。其中AbstractMap表明TreeMap为一个Map即支持key-value的集合, NavigableMap(更多)则意味着它支持一系列的导航方法,具备针对给定搜索目标返回最接近匹配项的导航方法 。 TreeMap中同时也包含了如下几个重要的属性: //比较器,因为TreeMap是有序的,通过comparator接口我们可以对TreeMap的内部排序进行精密的控制 private final Comparator<? super K> comparator; //TreeMap红-黑节点,为TreeMap的内部类 private transient Entry<K,V> root = null; //容器大小 private transient int size = 0; //TreeMap修改次数 private transient int modCount = 0; //红黑树的节点颜色--红色 private static final boolean RED = false; //红黑树的节点颜色--黑色 private static final boolean BLACK = true; 对于叶子节点Entry是TreeMap的内部类,它有几个重要的属性: //键 K key; //值 V value; //左孩子 Entry<K,V> left = null; //右孩子 Entry<K,V> right = null; //父亲 Entry<K,V> parent; //颜色 boolean color = BLACK; 注:前面只是开胃菜,下面是本篇博文的重中之重,在下面两节我将重点讲解treeMap的put()、delete()方法。通过这两个方法我们会了解红黑树增加、删除节点的核心算法。 三、TreeMap put()方法在了解TreeMap的put()方法之前,我们先了解红黑树增加节点的算法。 红黑树增加节点红黑树在新增节点过程中比较复杂,复杂归复杂它同样必须要依据上面提到的五点规范,同时由于规则1、2、3基本都会满足,下面我们主要讨论规则4、5。假设我们这里有一棵最简单的树,我们规定新增的节点为N、它的父节点为P、P的兄弟节点为U、P的父节点为G。

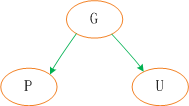

对于新节点的插入有如下三个关键地方: 1、插入新节点总是红色节点 。 2、如果插入节点的父节点是黑色, 能维持性质 。 3、如果插入节点的父节点是红色, 破坏了性质. 故插入算法就是通过重新着色或旋转, 来维持性质 。 为了保证下面的阐述更加清晰和根据便于参考,我这里将红黑树的五点规定再贴一遍: 1、每个节点都只能是红色或者黑色 2、根节点是黑色 3、每个叶节点(NIL节点,空节点)是黑色的。 4、如果一个结点是红的,则它两个子节点都是黑的。也就是说在一条路径上不能出现相邻的两个红色结点。 5、从任一节点到其每个叶子的所有路径都包含相同数目的黑色节点。 若新插入的节点N没有父节点,则直接当做根据节点插入即可,同时将颜色设置为黑色。(如图一(1)) 二、父节点为黑色 这种情况新节点N同样是直接插入,同时颜色为红色,由于根据规则四它会存在两个黑色的叶子节点,值为null。同时由于新增节点N为红色,所以通过它的子节点的路径依然会保存着相同的黑色节点数,同样满足规则5。(如图一(2))

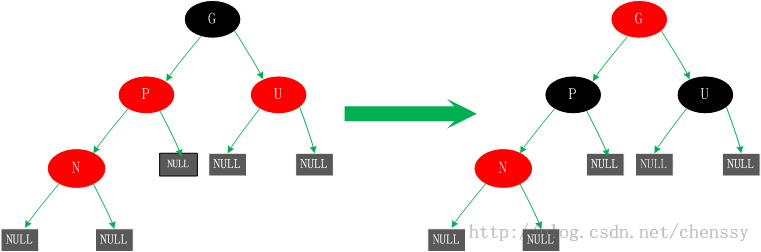

(图一) 三、若父节点P和P的兄弟节点U都为红色 对于这种情况若直接插入肯定会出现不平衡现象。怎么处理?P、U节点变黑、G节点变红。这时由于经过节点P、U的路径都必须经过G所以在这些路径上面的黑节点数目还是相同的。但是经过上面的处理,可能G节点的父节点也是红色,这个时候我们需要将G节点当做新增节点递归处理。

四、若父节点P为红色,叔父节点U为黑色或者缺少,且新增节点N为P节点的右孩子对于这种情况我们对新增节点N、P进行一次左旋转。这里所产生的结果其实并没有完成,还不是平衡的(违反了规则四),这是我们需要进行情况5的操作。

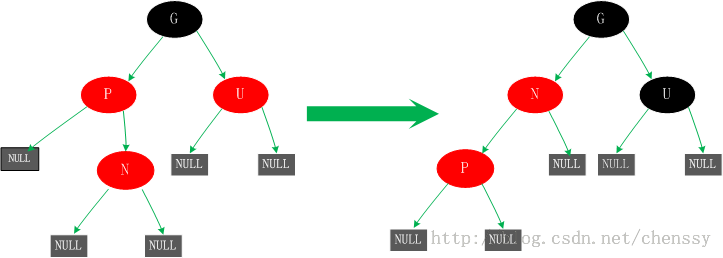

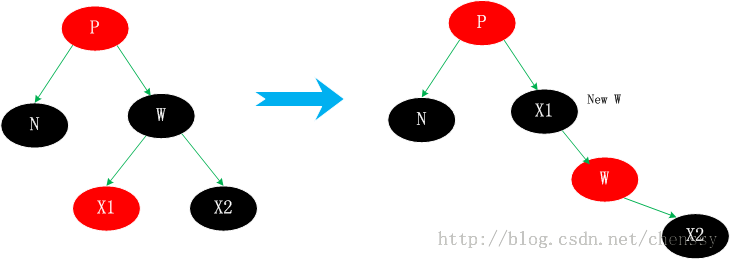

五、父节点P为红色,叔父节点U为黑色或者缺少,新增节点N为父节点P左孩子 这种情况有可能是由于情况四而产生的,也有可能不是。对于这种情况先已P节点为中心进行右旋转,在旋转后产生的树中,节点P是节点N、G的父节点。但是这棵树并不规范,它违反了规则4,所以我们将P、G节点的颜色进行交换,使之其满足规范。开始时所有的路径都需要经过G其他们的黑色节点数一样,但是现在所有的路径改为经过P,且P为整棵树的唯一黑色节点,所以调整后的树同样满足规范5。  上面展示了红黑树新增节点的五种情况,这五种情况涵盖了所有的新增可能,不管这棵红黑树多么复杂,都可以根据这五种情况来进行生成。下面就来分析Java中的TreeMap是如何来实现红黑树的。 TreeMap put()方法实现分析在TreeMap的put()的实现方法中主要分为两个步骤,第一:构建排序二叉树,第二:平衡二叉树。 对于排序二叉树的创建,其添加节点的过程如下: 1、以根节点为初始节点进行检索。 2、与当前节点进行比对,若新增节点值较大,则以当前节点的右子节点作为新的当前节点。否则以当前节点的左子节点作为新的当前节点。 3、循环递归2步骤知道检索出合适的叶子节点为止。 4、将新增节点与3步骤中找到的节点进行比对,如果新增节点较大,则添加为右子节点;否则添加为左子节点。 按照这个步骤我们就可以将一个新增节点添加到排序二叉树中合适的位置。如下: public V put(K key, V value) {

//用t表示二叉树的当前节点

Entry<K,V> t = root;

//t为null表示一个空树,即TreeMap中没有任何元素,直接插入

if (t == null) {

//比较key值,个人觉得这句代码没有任何意义,空树还需要比较、排序?

compare(key, key); // type (and possibly null) check

//将新的key-value键值对创建为一个Entry节点,并将该节点赋予给root

root = new Entry<>(key, value, null);

//容器的size = 1,表示TreeMap集合中存在一个元素

size = 1;

//修改次数 + 1

modCount++;

return null;

}

int cmp; //cmp表示key排序的返回结果

Entry<K,V> parent; //父节点

// split comparator and comparable paths

Comparator<? super K> cpr = comparator; //指定的排序算法

//如果cpr不为空,则采用既定的排序算法进行创建TreeMap集合

if (cpr != null) {

do {

parent = t; //parent指向上次循环后的t

//比较新增节点的key和当前节点key的大小

cmp = cpr.compare(key, t.key);

//cmp返回值小于0,表示新增节点的key小于当前节点的key,则以当前节点的左子节点作为新的当前节点

if (cmp < 0)

t = t.left;

//cmp返回值大于0,表示新增节点的key大于当前节点的key,则以当前节点的右子节点作为新的当前节点

else if (cmp > 0)

t = t.right;

//cmp返回值等于0,表示两个key值相等,则新值覆盖旧值,并返回新值

else

return t.setValue(value);

} while (t != null);

}

//如果cpr为空,则采用默认的排序算法进行创建TreeMap集合

else {

if (key == null) //key值为空抛出异常

throw new NullPointerException();

/* 下面处理过程和上面一样 */

Comparable<? super K> k = (Comparable<? super K>) key;

do {

parent = t;

cmp = k.compareTo(t.key);

if (cmp < 0)

t = t.left;

else if (cmp > 0)

t = t.right;

else

return t.setValue(value);

} while (t != null);

}

//将新增节点当做parent的子节点

Entry<K,V> e = new Entry<>(key, value, parent);

//如果新增节点的key小于parent的key,则当做左子节点

if (cmp < 0)

parent.left = e;

//如果新增节点的key大于parent的key,则当做右子节点

else

parent.right = e;

/*

* 上面已经完成了排序二叉树的的构建,将新增节点插入该树中的合适位置

* 下面fixAfterInsertion()方法就是对这棵树进行调整、平衡,具体过程参考上面的五种情况

*/

fixAfterInsertion(e);

//TreeMap元素数量 + 1

size++;

//TreeMap容器修改次数 + 1

modCount++;

return null;

}/**

* 新增节点后的修复操作

* x 表示新增节点

*/

private void fixAfterInsertion(Entry<K,V> x) {

x.color = RED; //新增节点的颜色为红色

//循环 直到 x不是根节点,且x的父节点不为红色

while (x != null && x != root && x.parent.color == RED) {

//如果X的父节点(P)是其父节点的父节点(G)的左节点

if (parentOf(x) == leftOf(parentOf(parentOf(x)))) {

//获取X的叔节点(U)

Entry<K,V> y = rightOf(parentOf(parentOf(x)));

//如果X的叔节点(U) 为红色(情况三)

if (colorOf(y) == RED) {

//将X的父节点(P)设置为黑色

setColor(parentOf(x), BLACK);

//将X的叔节点(U)设置为黑色

setColor(y, BLACK);

//将X的父节点的父节点(G)设置红色

setColor(parentOf(parentOf(x)), RED);

x = parentOf(parentOf(x));

}

//如果X的叔节点(U为黑色);这里会存在两种情况(情况四、情况五)

else {

//如果X节点为其父节点(P)的右子树,则进行左旋转(情况四)

if (x == rightOf(parentOf(x))) {

//将X的父节点作为X

x = parentOf(x);

//右旋转

rotateLeft(x);

}

//(情况五)

//将X的父节点(P)设置为黑色

setColor(parentOf(x), BLACK);

//将X的父节点的父节点(G)设置红色

setColor(parentOf(parentOf(x)), RED);

//以X的父节点的父节点(G)为中心右旋转

rotateRight(parentOf(parentOf(x)));

}

}

//如果X的父节点(P)是其父节点的父节点(G)的右节点

else {

//获取X的叔节点(U)

Entry<K,V> y = leftOf(parentOf(parentOf(x)));

//如果X的叔节点(U) 为红色(情况三)

if (colorOf(y) == RED) {

//将X的父节点(P)设置为黑色

setColor(parentOf(x), BLACK);

//将X的叔节点(U)设置为黑色

setColor(y, BLACK);

//将X的父节点的父节点(G)设置红色

setColor(parentOf(parentOf(x)), RED);

x = parentOf(parentOf(x));

}

//如果X的叔节点(U为黑色);这里会存在两种情况(情况四、情况五)

else {

//如果X节点为其父节点(P)的右子树,则进行左旋转(情况四)

if (x == leftOf(parentOf(x))) {

//将X的父节点作为X

x = parentOf(x);

//右旋转

rotateRight(x);

}

//(情况五)

//将X的父节点(P)设置为黑色

setColor(parentOf(x), BLACK);

//将X的父节点的父节点(G)设置红色

setColor(parentOf(parentOf(x)), RED);

//以X的父节点的父节点(G)为中心右旋转

rotateLeft(parentOf(parentOf(x)));

}

}

}

//将根节点G强制设置为黑色

root.color = BLACK;

}对这段代码的研究我们发现,其处理过程完全符合红黑树新增节点的处理过程。所以在看这段代码的过程一定要对红黑树的新增节点过程有了解。在这个代码中还包含几个重要的操作。左旋(rotateLeft())、右旋(rotateRight())、着色(setColor())。 左旋:rotateLeft() 所谓左旋转,就是将新增节点(N)当做其父节点(P),将其父节点P当做新增节点(N)的左子节点。即:G.left ---> N ,N.left ---> P。 右旋:rotateRight() private void rotateLeft(Entry<K,V> p) {

if (p != null) {

//获取P的右子节点,其实这里就相当于新增节点N(情况四而言)

Entry<K,V> r = p.right;

//将R的左子树设置为P的右子树

p.right = r.left;

//若R的左子树不为空,则将P设置为R左子树的父亲

if (r.left != null)

r.left.parent = p;

//将P的父亲设置R的父亲

r.parent = p.parent;

//如果P的父亲为空,则将R设置为跟节点

if (p.parent == null)

root = r;

//如果P为其父节点(G)的左子树,则将R设置为P父节点(G)左子树

else if (p.parent.left == p)

p.parent.left = r;

//否则R设置为P的父节点(G)的右子树

else

p.parent.right = r;

//将P设置为R的左子树

r.left = p;

//将R设置为P的父节点

p.parent = r;

}

}所谓右旋转即,P.right ---> G、G.parent ---> P。 private void rotateRight(Entry<K,V> p) {

if (p != null) {

//将L设置为P的左子树

Entry<K,V> l = p.left;

//将L的右子树设置为P的左子树

p.left = l.right;

//若L的右子树不为空,则将P设置L的右子树的父节点

if (l.right != null)

l.right.parent = p;

//将P的父节点设置为L的父节点

l.parent = p.parent;

//如果P的父节点为空,则将L设置根节点

if (p.parent == null)

root = l;

//若P为其父节点的右子树,则将L设置为P的父节点的右子树

else if (p.parent.right == p)

p.parent.right = l;

//否则将L设置为P的父节点的左子树

else

p.parent.left = l;

//将P设置为L的右子树

l.right = p;

//将L设置为P的父节点

p.parent = l;

}

}左旋、右旋的示意图如下:

(左旋) (右旋) (图片来自:http://www.cnblogs.com/yangecnu/p/Introduce-Red-Black-Tree.html) 着色:setColor() 着色就是改变该节点的颜色,在红黑树中,它是依靠节点的颜色来维持平衡的。 private static <K,V> void setColor(Entry<K,V> p, boolean c) {

if (p != null)

p.color = c;

}四、TreeMap delete()方法红黑树删除节点针对于红黑树的增加节点而言,删除显得更加复杂,使原本就复杂的红黑树变得更加复杂。同时删除节点和增加节点一样,同样是找到删除的节点,删除之后调整红黑树。但是这里的删除节点并不是直接删除,而是通过走了“弯路”通过一种捷径来删除的:找到被删除的节点D的子节点C,用C来替代D,不是直接删除D,因为D被C替代了,直接删除C即可。所以这里就将删除父节点D的事情转变为了删除子节点C的事情,这样处理就将复杂的删除事件简单化了。子节点C的规则是:右分支最左边,或者 左分支最右边的。  红-黑二叉树删除节点,最大的麻烦是要保持 各分支黑色节点数目相等。 因为是删除,所以不用担心存在颜色冲突问题——插入才会引起颜色冲突。 红黑树删除节点同样会分成几种情况,这里是按照待删除节点有几个儿子的情况来进行分类: 1、没有儿子,即为叶结点。直接把父结点的对应儿子指针设为NULL,删除儿子结点就OK了。 2、只有一个儿子。那么把父结点的相应儿子指针指向儿子的独生子,删除儿子结点也OK了。 3、有两个儿子。这种情况比较复杂,但还是比较简单。上面提到过用子节点C替代代替待删除节点D,然后删除子节点C即可。 下面就论各种删除情况来进行图例讲解,但是在讲解之前请允许我再次啰嗦一句,请时刻牢记红黑树的5点规定: 1、每个节点都只能是红色或者黑色 2、根节点是黑色 3、每个叶节点(NIL节点,空节点)是黑色的。 4、如果一个结点是红的,则它两个子节点都是黑的。也就是说在一条路径上不能出现相邻的两个红色结点。 5、从任一节点到其每个叶子的所有路径都包含相同数目的黑色节点。 (注:已经讲三遍了,再不记住我就怀疑你是否适合搞IT了 O(∩_∩)O~) 诚然,既然删除节点比较复杂,那么在这里我们就约定一下规则: 1、下面要讲解的删除节点一定是实际要删除节点的后继节点(N),如前面提到的C。 2、下面提到的删除节点的树都是如下结构,该结构所选取的节点是待删除节点的右树的最左边子节点。这里我们规定真实删除节点为N、父节点为P、兄弟节点为W兄弟节点的两个子节点为X1、X2。如下图(2.1)。  现在我们就上面提到的三种情况进行分析、处理。 情况一、无子节点(红色节点) 这种情况对该节点直接删除即可,不会影响树的结构。因为该节点为叶子节点它不可能存在子节点-----如子节点为黑,则违反黑节点数原则(规定5),为红,则违反“颜色”原则(规定4)。 如上图(2.2)。 情况二、有一个子节点 这种情况处理也是非常简单的,用子节点替代待删除节点,然后删除子节点即可。如上图(2.3) 情况三、有两个子节点 这种情况可能会稍微有点儿复杂。它需要找到一个替代待删除节点(N)来替代它,然后删除N即可。它主要分为四种情况。 1、N的兄弟节点W为红色 2、N的兄弟w是黑色的,且w的俩个孩子都是黑色的。 3、N的兄弟w是黑色的,w的左孩子是红色,w的右孩子是黑色。 4、N的兄弟w是黑色的,且w的右孩子时红色的。 情况3.1、N的兄弟节点W为红色 W为红色,那么其子节点X1、X2必定全部为黑色,父节点P也为黑色。处理策略是:改变W、P的颜色,然后进行一次左旋转。这样处理就可以使得红黑性质得以继续保持。N的新兄弟new w是旋转之前w的某个孩子,为黑色。这样处理后将情况3.1、转变为3.2、3.3、3.4中的一种。如下:

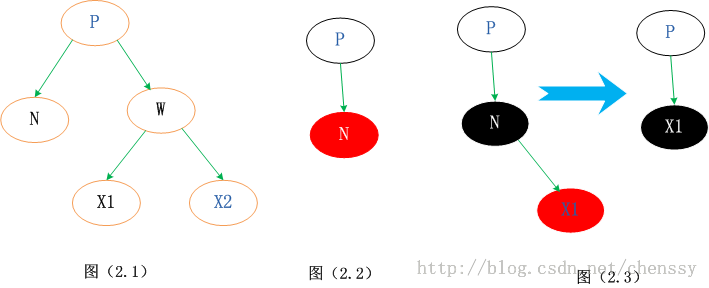

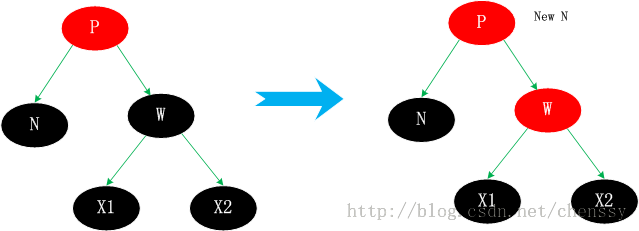

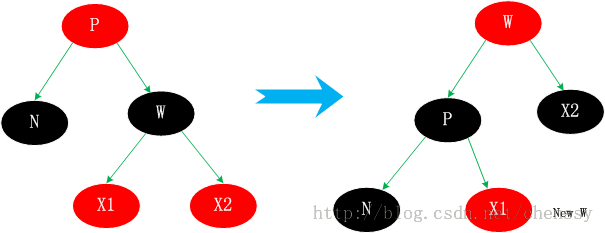

情况3.2、N的兄弟w是黑色的,且w的俩个孩子都是黑色的。 这种情况其父节点可红可黑,由于W为黑色,这样导致N子树相对于其兄弟W子树少一个黑色节点,这时我们可以将W置为红色。这样,N子树与W子树黑色节点一致,保持了平衡。如下  将W由黑转变为红,这样就会导致新节点new N相对于它的兄弟节点会少一个黑色节点。但是如果new x为红色,我们直接将new x转变为黑色,保持整棵树的平衡。否则情况3.2 会转变为情况3.1、3.3、3.4中的一种。 情况3.3、N的兄弟w是黑色的,w的左孩子是红色,w的右孩子是黑色。 针对这种情况是将节点W和其左子节点进行颜色交换,然后对W进行右旋转处理。  此时N的新兄弟X1(new w)是一个有红色右孩子的黑结点,于是将情况3转化为情况4. 情况3.4、N的兄弟w是黑色的,且w的右孩子时红色的。 交换W和父节点P的颜色,同时对P进行左旋转操作。这样就把左边缺失的黑色节点给补回来了。同时将W的右子节点X2置黑。这样左右都达到了平衡。  总结 个人认为这四种情况比较难理解,首先他们都不是单一的某种情况,他们之间是可以进行互转的。相对于其他的几种情况,情况3.2比较好理解,仅仅只是一个颜色的转变,通过减少右子树的一个黑色节点使之保持平衡,同时将不平衡点上移至N与W的父节点,然后进行下一轮迭代。情况3.1,是将W旋转将其转成情况2、3、4情况进行处理。而情况3.3通过转变后可以化成情况3.4来进行处理,从这里可以看出情况3.4应该最终结。情况3.4、右子节点为红色节点,那么将缺失的黑色节点交由给右子节点,通过旋转达到平衡。 通过上面的分析,我们已经初步了解了红黑树的删除节点情况,相对于增加节点而言它确实是选的较为复杂。下面我将看到在Java TreeMap中是如何实现红黑树删除的。 TreeMap deleteEntry()方法实现分析通过上面的分析我们确认删除节点的步骤是:找到一个替代子节点C来替代P,然后直接删除C,最后调整这棵红黑树。下面代码是寻找替代节点、删除替代节点。 private void deleteEntry(Entry<K,V> p) {

modCount++; //修改次数 +1

size--; //元素个数 -1

/*

* 被删除节点的左子树和右子树都不为空,那么就用 p节点的中序后继节点代替 p 节点

* successor(P)方法为寻找P的替代节点。规则是右分支最左边,或者 左分支最右边的节点

* ---------------------(1)

*/

if (p.left != null && p.right != null) {

Entry<K,V> s = successor(p);

p.key = s.key;

p.value = s.value;

p = s;

}

//replacement为替代节点,如果P的左子树存在那么就用左子树替代,否则用右子树替代

Entry<K,V> replacement = (p.left != null ? p.left : p.right);

/*

* 删除节点,分为上面提到的三种情况

* -----------------------(2)

*/

//如果替代节点不为空

if (replacement != null) {

replacement.parent = p.parent;

/*

*replacement来替代P节点

*/

//若P没有父节点,则跟节点直接变成replacement

if (p.parent == null)

root = replacement;

//如果P为左节点,则用replacement来替代为左节点

else if (p == p.parent.left)

p.parent.left = replacement;

//如果P为右节点,则用replacement来替代为右节点

else

p.parent.right = replacement;

//同时将P节点从这棵树中剔除掉

p.left = p.right = p.parent = null;

/*

* 若P为红色直接删除,红黑树保持平衡

* 但是若P为黑色,则需要调整红黑树使其保持平衡

*/

if (p.color == BLACK)

fixAfterDeletion(replacement);

} else if (p.parent == null) { //p没有父节点,表示为P根节点,直接删除即可

root = null;

} else { //P节点不存在子节点,直接删除即可

if (p.color == BLACK) //如果P节点的颜色为黑色,对红黑树进行调整

fixAfterDeletion(p);

//删除P节点

if (p.parent != null) {

if (p == p.parent.left)

p.parent.left = null;

else if (p == p.parent.right)

p.parent.right = null;

p.parent = null;

}

}

}(1)除是寻找替代节点replacement,其实现方法为successor()。如下: static <K,V> TreeMap.Entry<K,V> successor(Entry<K,V> t) {

if (t == null)

return null;

/*

* 寻找右子树的最左子树

*/

else if (t.right != null) {

Entry<K,V> p = t.right;

while (p.left != null)

p = p.left;

return p;

}

/*

* 选择左子树的最右子树

*/

else {

Entry<K,V> p = t.parent;

Entry<K,V> ch = t;

while (p != null && ch == p.right) {

ch = p;

p = p.parent;

}

return p;

}

}(2)处是删除该节点过程。它主要分为上面提到的三种情况,它与上面的if…else if… else一一对应 。如下: 1、有两个儿子。这种情况比较复杂,但还是比较简单。上面提到过用子节点C替代代替待删除节点D,然后删除子节点C即可。 2、没有儿子,即为叶结点。直接把父结点的对应儿子指针设为NULL,删除儿子结点就OK了。 3、只有一个儿子。那么把父结点的相应儿子指针指向儿子的独生子,删除儿子结点也OK了。 删除完节点后,就要根据情况来对红黑树进行复杂的调整:fixAfterDeletion()。 private void fixAfterDeletion(Entry<K,V> x) {

// 删除节点需要一直迭代,知道 直到 x 不是根节点,且 x 的颜色是黑色

while (x != root && colorOf(x) == BLACK) {

if (x == leftOf(parentOf(x))) { //若X节点为左节点

//获取其兄弟节点

Entry<K,V> sib = rightOf(parentOf(x));

/*

* 如果兄弟节点为红色----(情况3.1)

* 策略:改变W、P的颜色,然后进行一次左旋转

*/

if (colorOf(sib) == RED) {

setColor(sib, BLACK);

setColor(parentOf(x), RED);

rotateLeft(parentOf(x));

sib = rightOf(parentOf(x));

}

/*

* 若兄弟节点的两个子节点都为黑色----(情况3.2)

* 策略:将兄弟节点编程红色

*/

if (colorOf(leftOf(sib)) == BLACK &&

colorOf(rightOf(sib)) == BLACK) {

setColor(sib, RED);

x = parentOf(x);

}

else {

/*

* 如果兄弟节点只有右子树为黑色----(情况3.3)

* 策略:将兄弟节点与其左子树进行颜色互换然后进行右转

* 这时情况会转变为3.4

*/

if (colorOf(rightOf(sib)) == BLACK) {

setColor(leftOf(sib), BLACK);

setColor(sib, RED);

rotateRight(sib);

sib = rightOf(parentOf(x));

}

/*

*----情况3.4

*策略:交换兄弟节点和父节点的颜色,

*同时将兄弟节点右子树设置为黑色,最后左旋转

*/

setColor(sib, colorOf(parentOf(x)));

setColor(parentOf(x), BLACK);

setColor(rightOf(sib), BLACK);

rotateLeft(parentOf(x));

x = root;

}

}

/**

* X节点为右节点与其为做节点处理过程差不多,这里就不在累述了

*/

else {

Entry<K,V> sib = leftOf(parentOf(x));

if (colorOf(sib) == RED) {

setColor(sib, BLACK);

setColor(parentOf(x), RED);

rotateRight(parentOf(x));

sib = leftOf(parentOf(x));

}

if (colorOf(rightOf(sib)) == BLACK &&

colorOf(leftOf(sib)) == BLACK) {

setColor(sib, RED);

x = parentOf(x);

} else {

if (colorOf(leftOf(sib)) == BLACK) {

setColor(rightOf(sib), BLACK);

setColor(sib, RED);

rotateLeft(sib);

sib = leftOf(parentOf(x));

}

setColor(sib, colorOf(parentOf(x)));

setColor(parentOf(x), BLACK);

setColor(leftOf(sib), BLACK);

rotateRight(parentOf(x));

x = root;

}

}

}

setColor(x, BLACK);

} 这是红黑树在删除节点后,对树的平衡性进行调整的过程,其实现过程与上面四种复杂的情况一一对应,所以在这个源码的时候一定要对着上面提到的四种情况看。五、写在最后这篇博文确实是有点儿长,在这里非常感谢各位看客能够静下心来读完,我想你通过读完这篇博文一定收获不小。同时这篇博文很大篇幅都在阐述红黑树的实现过程,对Java 的TreeMap聊的比较少,但是我认为如果理解了红黑树的实现过程,对TreeMap那是手到擒来,小菜一碟。 同时这篇博文我写了四天,看了、参考了大量的博文。同时不免会有些地方存在借鉴之处,在这里对其表示感谢。LZ大二开始学习数据结构,自认为学的不错,现在发现数据结构我还有太多的地方需要学习了,同时也再一次体味了算法的魅力!!!!

参考资料: 1、红黑树数据结构剖析:http://www.cnblogs.com/fanzhidongyzby/p/3187912.html 2、红黑二叉树详解及理论分析 :http://blog.csdn.net/kartorz/article/details/8865997 3、教你透彻了解红黑树 :blog.csdn.net/v_july_v/article/details/6105630 4、经典算法研究系列:五、红黑树算法的实现与剖析 :http://blog.csdn.net/v_JULY_v/article/details/6109153 5、示例,红黑树插入和删除过程:http://saturnman.blog.163.com/blog/static/557611201097221570/ 6、红黑二叉树详解及理论分析 :http://blog.csdn.net/kartorz/article/details/8865997 原文出自:http://cmsblogs.com/?p=1013。尊重作者的成果,转载请注明出处! 个人站点:http://cmsblogs.com

作者:chenssy 发表于2014/5/23 9:23:51 原文链接

阅读:35121 评论:34 查看评论

| ||||||||||||

| Java提高篇(二六)------hashCode | ||||||||||||

|

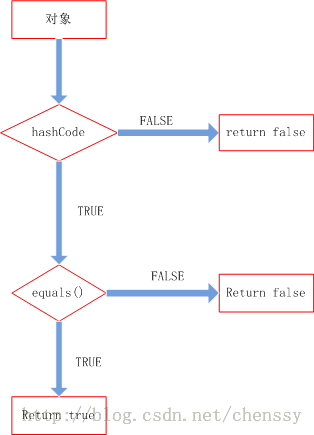

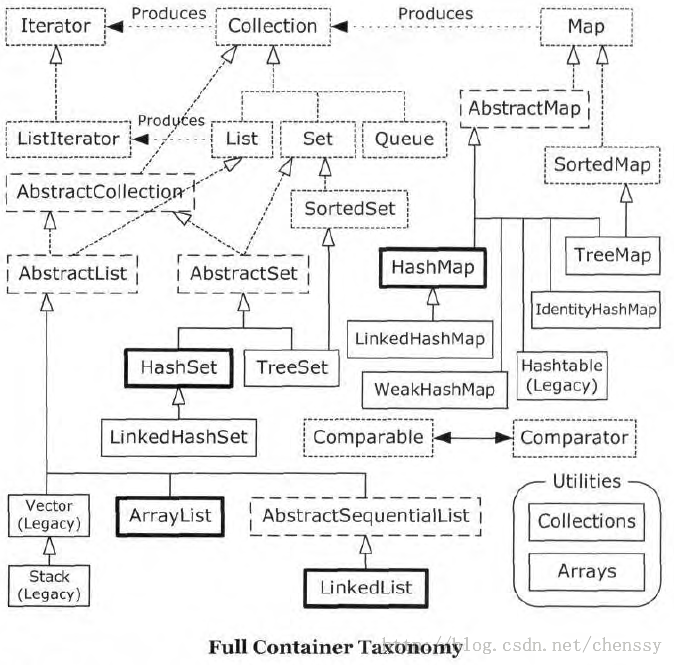

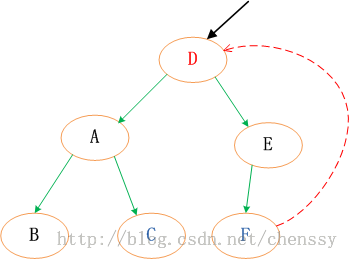

原文出自:http://cmsblogs.com/?p=631。尊重作者的成果,转载请注明出处! 个人站点:http://cmsblogs.com ----------------------------------------------------------------------------------------------------------------------------------------------------------------------------在前面三篇博文中LZ讲解了(HashMap、HashSet、HashTable),在其中LZ不断地讲解他们的put和get方法,在这两个方法中计算key的hashCode应该是最重要也是最精华的部分,所以下面LZ揭开hashCode的“神秘”面纱。 hashCode的作用要想了解一个方法的内在原理,我们首先需要明白它是干什么的,也就是这个方法的作用。在讲解数组时(java提高篇(十八)------数组),我们提到数组是java中效率最高的数据结构,但是“最高”是有前提的。第一我们需要知道所查询数据的所在位置。第二:如果我们进行迭代查找时,数据量一定要小,对于大数据量而言一般推荐集合。 在Java集合中有两类,一类是List,一类是Set他们之间的区别就在于List集合中的元素师有序的,且可以重复,而Set集合中元素是无序不可重复的。对于List好处理,但是对于Set而言我们要如何来保证元素不重复呢?通过迭代来equals()是否相等。数据量小还可以接受,当我们的数据量大的时候效率可想而知(当然我们可以利用算法进行优化)。比如我们向HashSet插入1000数据,难道我们真的要迭代1000次,调用1000次equals()方法吗?hashCode提供了解决方案。怎么实现?我们先看hashCode的源码(Object)。 public native int hashCode(); 它是一个本地方法,它的实现与本地机器有关,这里我们暂且认为他返回的是对象存储的物理位置(实际上不是,这里写是便于理解)。当我们向一个集合中添加某个元素,集合会首先调用hashCode方法,这样就可以直接定位它所存储的位置,若该处没有其他元素,则直接保存。若该处已经有元素存在,就调用equals方法来匹配这两个元素是否相同,相同则不存,不同则散列到其他位置(具体情况请参考(Java提高篇()-----HashMap))。这样处理,当我们存入大量元素时就可以大大减少调用equals()方法的次数,极大地提高了效率。 所以hashCode在上面扮演的角色为寻域(寻找某个对象在集合中区域位置)。hashCode可以将集合分成若干个区域,每个对象都可以计算出他们的hash码,可以将hash码分组,每个分组对应着某个存储区域,根据一个对象的hash码就可以确定该对象所存储区域,这样就大大减少查询匹配元素的数量,提高了查询效率。 hashCode对于一个对象的重要性hashCode重要么?不重要,对于List集合、数组而言,他就是一个累赘,但是对于HashMap、HashSet、HashTable而言,它变得异常重要。所以在使用HashMap、HashSet、HashTable时一定要注意hashCode。对于一个对象而言,其hashCode过程就是一个简单的Hash算法的实现,其实现过程对你实现对象的存取过程起到非常重要的作用。 在前面LZ提到了HashMap和HashTable两种数据结构,虽然他们存在若干个区别,但是他们的实现原理是相同的,这里我以HashTable为例阐述hashCode对于一个对象的重要性。 一个对象势必会存在若干个属性,如何选择属性来进行散列考验着一个人的设计能力。如果我们将所有属性进行散列,这必定会是一个糟糕的设计,因为对象的hashCode方法无时无刻不是在被调用,如果太多的属性参与散列,那么需要的操作数时间将会大大增加,这将严重影响程序的性能。但是如果较少属相参与散列,散列的多样性会削弱,会产生大量的散列“冲突”,除了不能够很好的利用空间外,在某种程度也会影响对象的查询效率。其实这两者是一个矛盾体,散列的多样性会带来性能的降低。 那么如何对对象的hashCode进行设计,LZ也没有经验。从网上查到了这样一种解决方案:设置一个缓存标识来缓存当前的散列码,只有当参与散列的对象改变时才会重新计算,否则调用缓存的hashCode,这样就可以从很大程度上提高性能。 在HashTable计算某个对象在table[]数组中的索引位置,其代码如下: int index = (hash & 0x7FFFFFFF) % tab.length; 为什么要&0x7FFFFFFF?因为某些对象的hashCode可能会为负值,与0x7FFFFFFF进行与运算可以确保index为一个正数。通过这步我可以直接定位某个对象的位置,所以从理论上来说我们是完全可以利用hashCode直接定位对象的散列表中的位置,但是为什么会存在一个key-value的键值对,利用key的hashCode来存入数据而不是直接存放value呢?这就关系HashTable性能问题的最重要的问题:Hash冲突! 我们知道冲突的产生是由于不同的对象产生了相同的散列码,假如我们设计对象的散列码可以确保99.999999999%的不重复,但是有一种绝对且几乎不可能遇到的冲突你是绝对避免不了的。我们知道hashcode返回的是int,它的值只可能在int范围内。如果我们存放的数据超过了int的范围呢?这样就必定会产生两个相同的index,这时在index位置处会存储两个对象,我们就可以利用key本身来进行判断。所以具有相索引的对象,在该index位置处存在多个对象,我们必须依靠key的hashCode和key本身来进行区分。 hashCode与equals在Java中hashCode的实现总是伴随着equals,他们是紧密配合的,你要是自己设计了其中一个,就要设计另外一个。当然在多数情况下,这两个方法是不用我们考虑的,直接使用默认方法就可以帮助我们解决很多问题。但是在有些情况,我们必须要自己动手来实现它,才能确保程序更好的运作。 对于equals,我们必须遵循如下规则: 对称性:如果x.equals(y)返回是“true”,那么y.equals(x)也应该返回是“true”。 反射性:x.equals(x)必须返回是“true”。 类推性:如果x.equals(y)返回是“true”,而且y.equals(z)返回是“true”,那么z.equals(x)也应该返回是“true”。 一致性:如果x.equals(y)返回是“true”,只要x和y内容一直不变,不管你重复x.equals(y)多少次,返回都是“true”。 任何情况下,x.equals(null),永远返回是“false”;x.equals(和x不同类型的对象)永远返回是“false”。 对于hashCode,我们应该遵循如下规则: 1. 在一个应用程序执行期间,如果一个对象的equals方法做比较所用到的信息没有被修改的话,则对该对象调用hashCode方法多次,它必须始终如一地返回同一个整数。 2. 如果两个对象根据equals(Object o)方法是相等的,则调用这两个对象中任一对象的hashCode方法必须产生相同的整数结果。 3. 如果两个对象根据equals(Object o)方法是不相等的,则调用这两个对象中任一个对象的hashCode方法,不要求产生不同的整数结果。但如果能不同,则可能提高散列表的性能。 至于两者之间的关联关系,我们只需要记住如下即可: 如果x.equals(y)返回“true”,那么x和y的hashCode()必须相等。 如果x.equals(y)返回“false”,那么x和y的hashCode()有可能相等,也有可能不等。 理清了上面的关系我们就知道他们两者是如何配合起来工作的。先看下图:

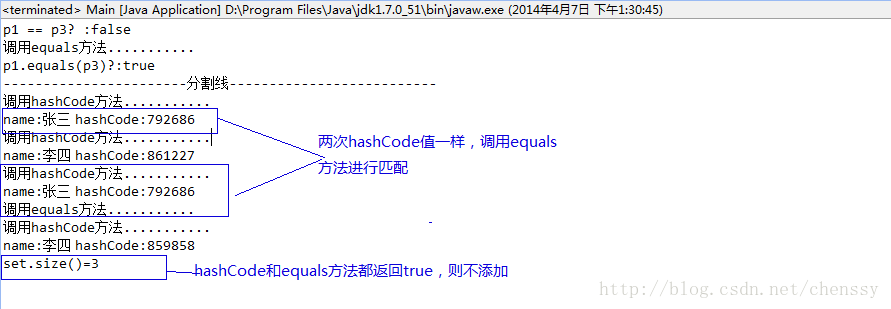

整个处理流程是: 1、判断两个对象的hashcode是否相等,若不等,则认为两个对象不等,完毕,若相等,则比较equals。 2、若两个对象的equals不等,则可以认为两个对象不等,否则认为他们相等。 实例: public class Person {

private int age;

private int sex; //0:男,1:女

private String name;

private final int PRIME = 37;

Person(int age ,int sex ,String name){

this.age = age;

this.sex = sex;

this.name = name;

}

/** 省略getter、setter方法 **/

@Override

public int hashCode() {

System.out.println("调用hashCode方法...........");

int hashResult = 1;

hashResult = (hashResult + Integer.valueOf(age).hashCode() + Integer.valueOf(sex).hashCode()) * PRIME;

hashResult = PRIME * hashResult + ((name == null) ? 0 : name.hashCode());

System.out.println("name:"+name +" hashCode:" + hashResult);

return hashResult;

}

/**

* 重写hashCode()

*/

public boolean equals(Object obj) {

System.out.println("调用equals方法...........");

if(obj == null){

return false;

}

if(obj.getClass() != this.getClass()){

return false;

}

if(this == obj){

return true;

}

Person person = (Person) obj;

if(getAge() != person.getAge() || getSex()!= person.getSex()){

return false;

}

if(getName() != null){

if(!getName().equals(person.getName())){

return false;

}

}

else if(person != null){

return false;

}

return true;

}

}该Bean为一个标准的Java Bean,重新实现了hashCode方法和equals方法。 public class Main extends JPanel {

public static void main(String[] args) {

Set<Person> set = new HashSet<Person>();

Person p1 = new Person(11, 1, "张三");

Person p2 = new Person(12, 1, "李四");

Person p3 = new Person(11, 1, "张三");

Person p4 = new Person(11, 1, "李四");

//只验证p1、p3

System.out.println("p1 == p3? :" + (p1 == p3));

System.out.println("p1.equals(p3)?:"+p1.equals(p3));

System.out.println("-----------------------分割线--------------------------");

set.add(p1);

set.add(p2);

set.add(p3);

set.add(p4);

System.out.println("set.size()="+set.size());

}

}运行结果如下:

从上图可以看出,程序调用四次hashCode方法,一次equals方法,其set的长度只有3。add方法运行流程完全符合他们两者之间的处理流程。 更多请关注: >>>>>>>>>Java提高篇(十三)------equals() >>>>>>>>>Java提高篇(二三)------HashMap >>>>>>>>>Java提高篇(二四)------HashSet >>>>>>>>>Java提高篇(二五)------HashTable 原文出自:http://cmsblogs.com/?p=631。尊重作者的成果,转载请注明出处! 个人站点:http://cmsblogs.com

作者:chenssy 发表于2014/4/9 21:44:05 原文链接

阅读:2815 评论:2 查看评论

| ||||||||||||

| java提高篇(二五)-----HashTable | ||||||||||||

|

原文出自:http://cmsblogs.com/?p=618。尊重作者的成果,转载请注明出处! 个人站点:http://cmsblogs.com ---------------------------------------------------------------------------------------------------------------------------------------------------------------------------- 有两个类都提供了一个多种用途的hashTable机制,他们都可以将可以key和value结合起来构成键值对通过put(key,value)方法保存起来,然后通过get(key)方法获取相对应的value值。一个是前面提到的HashMap,还有一个就是马上要讲解的HashTable。对于HashTable而言,它在很大程度上和HashMap的实现差不多,如果我们对HashMap比较了解的话,对HashTable的认知会提高很大的帮助。他们两者之间只存在几点的不同,这个后面会阐述。 一、定义HashTable在Java中的定义如下: public class Hashtable<K,V>

extends Dictionary<K,V>

implements Map<K,V>, Cloneable, java.io.Serializable 从中可以看出HashTable继承Dictionary类,实现Map接口。其中Dictionary类是任何可将键映射到相应值的类(如 HashTable采用"拉链法"实现哈希表,它定义了几个重要的参数:table、count、threshold、loadFactor、modCount。 table:为一个Entry[]数组类型,Entry代表了“拉链”的节点,每一个Entry代表了一个键值对,哈希表的"key-value键值对"都是存储在Entry数组中的。 count:HashTable的大小,注意这个大小并不是HashTable的容器大小,而是他所包含Entry键值对的数量。 threshold:Hashtable的阈值,用于判断是否需要调整Hashtable的容量。threshold的值="容量*加载因子"。 loadFactor:加载因子。 modCount:用来实现“fail-fast”机制的(也就是快速失败)。所谓快速失败就是在并发集合中,其进行迭代操作时,若有其他线程对其进行结构性的修改,这时迭代器会立马感知到,并且立即抛出ConcurrentModificationException异常,而不是等到迭代完成之后才告诉你(你已经出错了)。 二、构造方法在HashTabel中存在5个构造函数。通过这5个构造函数我们构建出一个我想要的HashTable。 public Hashtable() {

this(11, 0.75f);

}默认构造函数,容量为11,加载因子为0.75。 public Hashtable(int initialCapacity) {

this(initialCapacity, 0.75f);

}用指定初始容量和默认的加载因子 (0.75) 构造一个新的空哈希表。 public Hashtable(int initialCapacity, float loadFactor) {

//验证初始容量

if (initialCapacity < 0)

throw new IllegalArgumentException("Illegal Capacity: "+

initialCapacity);

//验证加载因子

if (loadFactor <= 0 || Float.isNaN(loadFactor))

throw new IllegalArgumentException("Illegal Load: "+loadFactor);

if (initialCapacity==0)

initialCapacity = 1;

this.loadFactor = loadFactor;

//初始化table,获得大小为initialCapacity的table数组

table = new Entry[initialCapacity];

//计算阀值

threshold = (int)Math.min(initialCapacity * loadFactor, MAX_ARRAY_SIZE + 1);

//初始化HashSeed值

initHashSeedAsNeeded(initialCapacity);

}用指定初始容量和指定加载因子构造一个新的空哈希表。其中initHashSeedAsNeeded方法用于初始化hashSeed参数,其中hashSeed用于计算key的hash值,它与key的hashCode进行按位异或运算。这个hashSeed是一个与实例相关的随机值,主要用于解决hash冲突。 private int hash(Object k) {

return hashSeed ^ k.hashCode();

}构造一个与给定的 Map 具有相同映射关系的新哈希表。 public Hashtable(Map<? extends K, ? extends V> t) {

//设置table容器大小,其值==t.size * 2 + 1

this(Math.max(2*t.size(), 11), 0.75f);

putAll(t);

}三、主要方法HashTable的API对外提供了许多方法,这些方法能够很好帮助我们操作HashTable,但是这里我只介绍两个最根本的方法:put、get。 首先我们先看put方法:将指定 public synchronized V put(K key, V value) {

// 确保value不为null

if (value == null) {

throw new NullPointerException();

}

/*

* 确保key在table[]是不重复的

* 处理过程:

* 1、计算key的hash值,确认在table[]中的索引位置

* 2、迭代index索引位置,如果该位置处的链表中存在一个一样的key,则替换其value,返回旧值

*/

Entry tab[] = table;

int hash = hash(key); //计算key的hash值

int index = (hash & 0x7FFFFFFF) % tab.length; //确认该key的索引位置

//迭代,寻找该key,替换

for (Entry<K,V> e = tab[index] ; e != null ; e = e.next) {

if ((e.hash == hash) && e.key.equals(key)) {

V old = e.value;

e.value = value;

return old;

}

}

modCount++;

if (count >= threshold) { //如果容器中的元素数量已经达到阀值,则进行扩容操作

rehash();

tab = table;

hash = hash(key);

index = (hash & 0x7FFFFFFF) % tab.length;

}

// 在索引位置处插入一个新的节点

Entry<K,V> e = tab[index];

tab[index] = new Entry<>(hash, key, value, e);

//容器中元素+1

count++;

return null;

}put方法的整个处理流程是:计算key的hash值,根据hash值获得key在table数组中的索引位置,然后迭代该key处的Entry链表(我们暂且理解为链表),若该链表中存在一个这个的key对象,那么就直接替换其value值即可,否则在将改key-value节点插入该index索引位置处。如下: 首先我们假设一个容量为5的table,存在8、10、13、16、17、21。他们在table中位置如下:

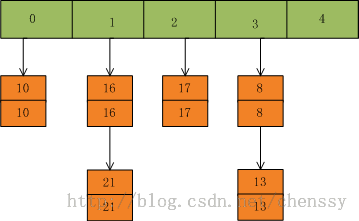

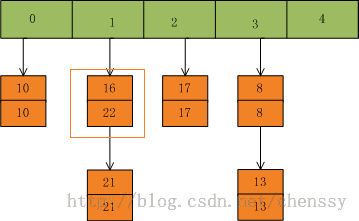

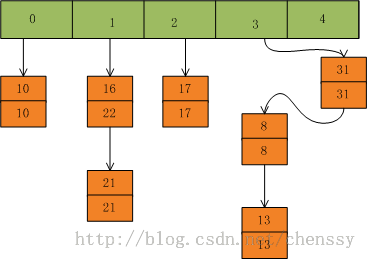

然后我们插入一个数:put(16,22),key=16在table的索引位置为1,同时在1索引位置有两个数,程序对该“链表”进行迭代,发现存在一个key=16,这时要做的工作就是用newValue=22替换oldValue16,并将oldValue=16返回。

在put(33,33),key=33所在的索引位置为3,并且在该链表中也没有存在某个key=33的节点,所以就将该节点插入该链表的第一个位置。

在HashTabled的put方法中有两个地方需要注意: 1、HashTable的扩容操作,在put方法中,如果需要向table[]中添加Entry元素,会首先进行容量校验,如果容量已经达到了阀值,HashTable就会进行扩容处理rehash(),如下: protected void rehash() {

int oldCapacity = table.length;

//元素

Entry<K,V>[] oldMap = table;

//新容量=旧容量 * 2 + 1

int newCapacity = (oldCapacity << 1) + 1;

if (newCapacity - MAX_ARRAY_SIZE > 0) {

if (oldCapacity == MAX_ARRAY_SIZE)

return;

newCapacity = MAX_ARRAY_SIZE;

}

//新建一个size = newCapacity 的HashTable

Entry<K,V>[] newMap = new Entry[];

modCount++;

//重新计算阀值

threshold = (int)Math.min(newCapacity * loadFactor, MAX_ARRAY_SIZE + 1);

//重新计算hashSeed

boolean rehash = initHashSeedAsNeeded(newCapacity);

table = newMap;

//将原来的元素拷贝到新的HashTable中

for (int i = oldCapacity ; i-- > 0 ;) {

for (Entry<K,V> old = oldMap[i] ; old != null ; ) {

Entry<K,V> e = old;

old = old.next;

if (rehash) {

e.hash = hash(e.key);

}

int index = (e.hash & 0x7FFFFFFF) % newCapacity;

e.next = newMap[index];

newMap[index] = e;

}

}

}在这个rehash()方法中我们可以看到容量扩大两倍+1,同时需要将原来HashTable中的元素一一复制到新的HashTable中,这个过程是比较消耗时间的,同时还需要重新计算hashSeed的,毕竟容量已经变了。这里对阀值啰嗦一下:比如初始值11、加载因子默认0.75,那么这个时候阀值threshold=8,当容器中的元素达到8时,HashTable进行一次扩容操作,容量 = 8 * 2 + 1 =17,而阀值threshold=17*0.75 = 13,当容器元素再一次达到阀值时,HashTable还会进行扩容操作,一次类推。 2、其实这里是我的一个疑问,在计算索引位置index时,HashTable进行了一个与运算过程(hash & 0x7FFFFFFF),为什么需要做一步操作,这么做有什么好处?如果哪位知道,望指导,LZ不胜感激!!下面是计算key的hash值,这里hashSeed发挥了作用。 private int hash(Object k) {

return hashSeed ^ k.hashCode();

}相对于put方法,get方法就会比较简单,处理过程就是计算key的hash值,判断在table数组中的索引位置,然后迭代链表,匹配直到找到相对应key的value,若没有找到返回null。 public synchronized V get(Object key) {

Entry tab[] = table;

int hash = hash(key);

int index = (hash & 0x7FFFFFFF) % tab.length;

for (Entry<K,V> e = tab[index] ; e != null ; e = e.next) {

if ((e.hash == hash) && e.key.equals(key)) {

return e.value;

}

}

return null;

}四、HashTable与HashMap的区别HashTable和HashMap存在很多的相同点,但是他们还是有几个比较重要的不同点。 第一:我们从他们的定义就可以看出他们的不同,HashTable基于Dictionary类,而HashMap是基于AbstractMap。Dictionary是什么?它是任何可将键映射到相应值的类的抽象父类,而AbstractMap是基于Map接口的骨干实现,它以最大限度地减少实现此接口所需的工作。 第二:HashMap可以允许存在一个为null的key和任意个为null的value,但是HashTable中的key和value都不允许为null。如下: 当HashMap遇到为null的key时,它会调用putForNullKey方法来进行处理。对于value没有进行任何处理,只要是对象都可以。 if (key == null)

return putForNullKey(value);而当HashTable遇到null时,他会直接抛出NullPointerException异常信息。 if (value == null) {

throw new NullPointerException();

}第三:Hashtable的方法是同步的,而HashMap的方法不是。所以有人一般都建议如果是涉及到多线程同步时采用HashTable,没有涉及就采用HashMap,但是在Collections类中存在一个静态方法:synchronizedMap(),该方法创建了一个线程安全的Map对象,并把它作为一个封装的对象来返回,所以通过Collections类的synchronizedMap方法是可以我们你同步访问潜在的HashMap。这样君该如何选择呢??? -------------------------------------------------------------------------------------------------------------------------------------------------------------------------- 原文出自:http://cmsblogs.com/?p=618。尊重作者的成果,转载请注明出处! 个人站点:http://cmsblogs.com

作者:chenssy 发表于2014/4/3 21:44:28 原文链接

阅读:16958 评论:15 查看评论

| ||||||||||||

| java提高篇(二四)-----HashSet | ||||||||||||

|

原文出自:http://cmsblogs.com/?p=599 在前篇博文中(java提高篇(二三)-----HashMap)详细讲解了HashMap的实现过程,对于HashSet而言,它是基于HashMap来实现的,底层采用HashMap来保存元素。所以如果对HashMap比较熟悉,那么HashSet是so easy!! 一、定义public class HashSet<E>

extends AbstractSet<E>

implements Set<E>, Cloneable, java.io.SerializableHashSet继承AbstractSet类,实现Set、Cloneable、Serializable接口。其中AbstractSet提供 Set 接口的骨干实现,从而最大限度地减少了实现此接口所需的工作。Set接口是一种不包括重复元素的Collection,它维持它自己的内部排序,所以随机访问没有任何意义。 基本属性 //基于HashMap实现,底层使用HashMap保存所有元素 private transient HashMap<E,Object> map; //定义一个Object对象作为HashMap的value private static final Object PRESENT = new Object(); 构造函数 /**

* 默认构造函数

* 初始化一个空的HashMap,并使用默认初始容量为16和加载因子0.75。

*/

public HashSet() {

map = new HashMap<>();

}

/**

* 构造一个包含指定 collection 中的元素的新 set。

*/

public HashSet(Collection<? extends E> c) {

map = new HashMap<>(Math.max((int) (c.size()/.75f) + 1, 16));

addAll(c);

}

/**

* 构造一个新的空 set,其底层 HashMap 实例具有指定的初始容量和指定的加载因子

*/

public HashSet(int initialCapacity, float loadFactor) {

map = new HashMap<>(initialCapacity, loadFactor);

}

/**

* 构造一个新的空 set,其底层 HashMap 实例具有指定的初始容量和默认的加载因子(0.75)。

*/

public HashSet(int initialCapacity) {